Linux基本命令

- 终端: 一系列输入输出设备的总称

- 终端内嵌入了

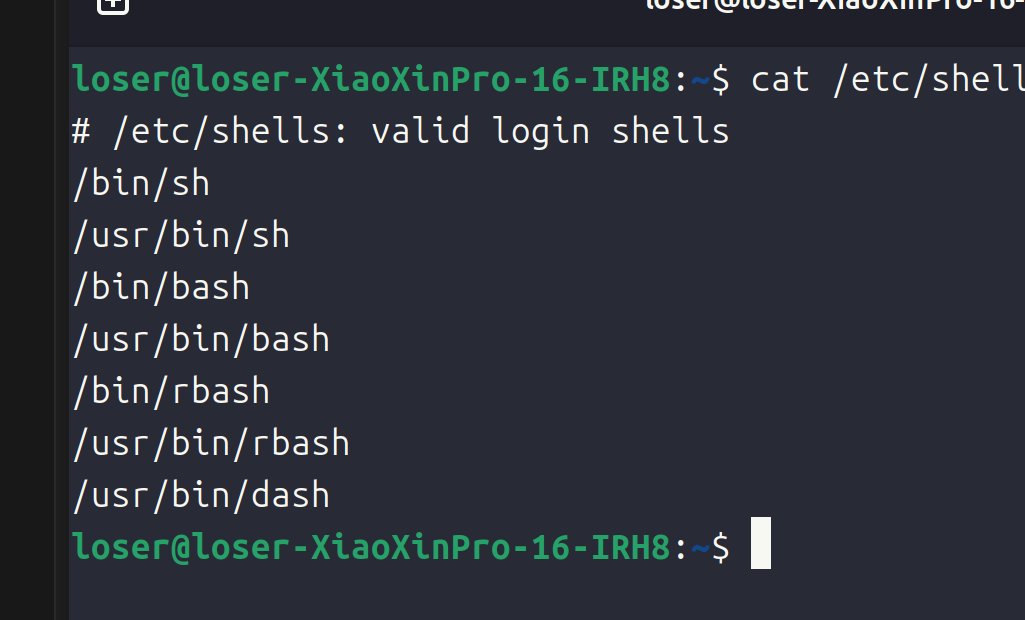

shell,可以执行输入的命令 - 可以查看

/etc/shells查看shell,$SHELL就是现在使用的shell解析器 shell中可以使用的快捷键如下:

| 功能 | 快捷键 | 含义 |

|---|---|---|

| 上 | ctrl+p | previous |

| 下 | ctrl+n | next |

| 左 | ctrl+b | backforward |

| 右 | ctrl+f | forward |

Del | ctrl+d | delete光标之后的 |

Home | ctrl+a | the first letter |

End | ctrl+e | end |

Backspace | Backspace | delete光标之前的 |

类Unix的目录结构

Linux操作系统中一切都是文件Linux的目录结构如下:/dev存放各种设备相关的文件/etc存放相关的配置文件信息,比如/etc/passwd存放着用户的密码和信息/home表示用户目录,进入之后可以看到用户目录/lib表示库目录,使用的所有库都放在这一个/lib中(比如C库等)/root表示root用户的家目录/bin存放着各种命令/usr存放着各种软件资源,安装的各种软件资源都放在/usr中,自己装的软件可以放在/usr/local中/boot存放开机启动程序

文件和目录操作

~表示家目录- 文件类型(

shell编程中提到过):-普通文件d目录文件c字符设备文件(按照字节进行读写)b块设备文件(可以随机读写)l软连接p管道s套接字

rmdir删除空目录(一般使用rm -r)mkdir -p a/b表示递归的创建文件夹cp -a dir ..表示把dir全部拷贝到..中,否则就会略过dir,-a会把所有的信息(包含权限拷贝过去,甚至时间都会被拷贝过去)cat查看文件内容tac表示倒置显示,比如可以查看日志文件可以使用这一个more表示分割显示(空格翻页,enter一行,q退出)less基本一致,但是无法使用ctrl + C退出head读取头部tail读取尾部du查看目录大小df查看磁盘挂载点和使用情况- 不会的命令使用

--help查看帮助文档

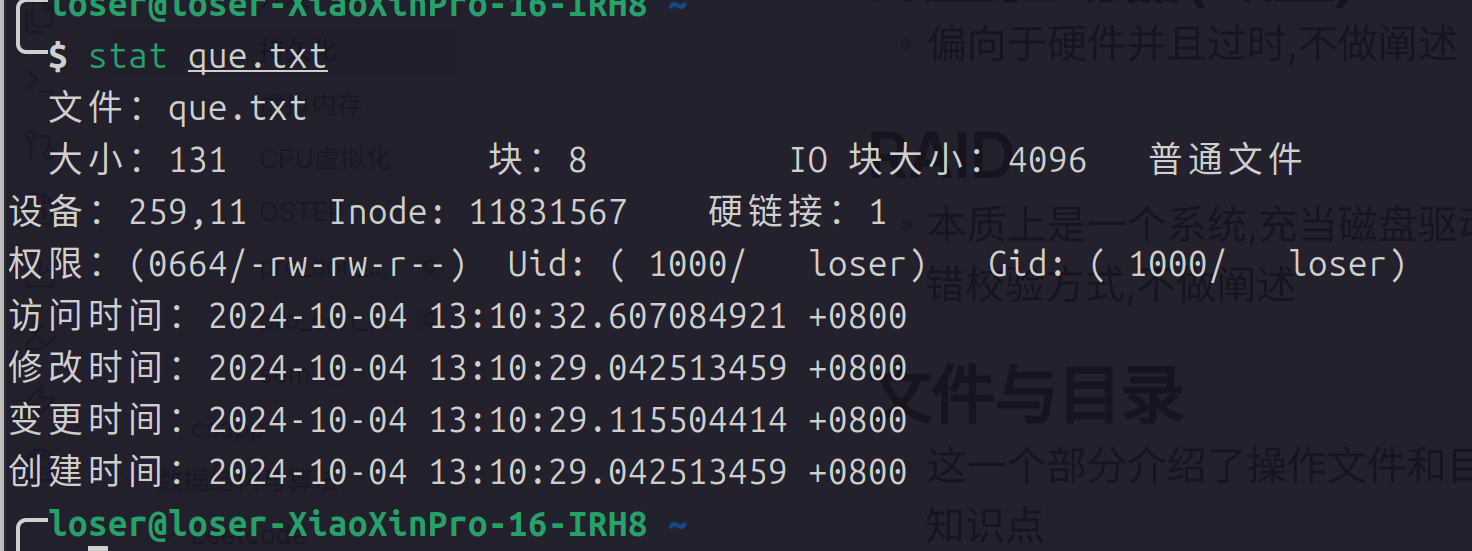

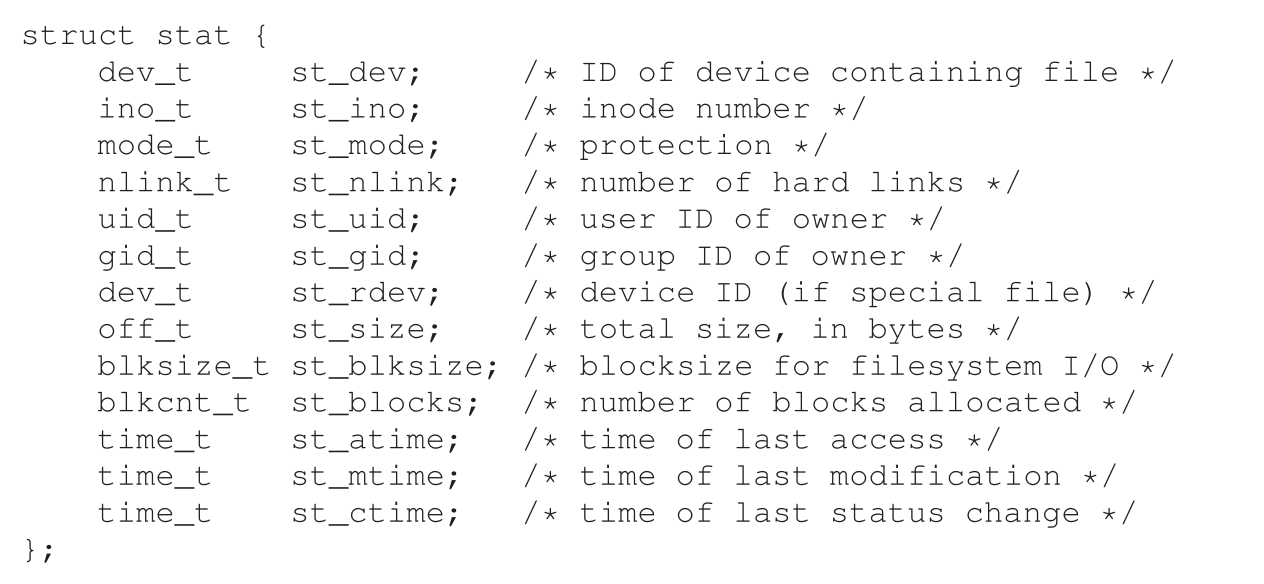

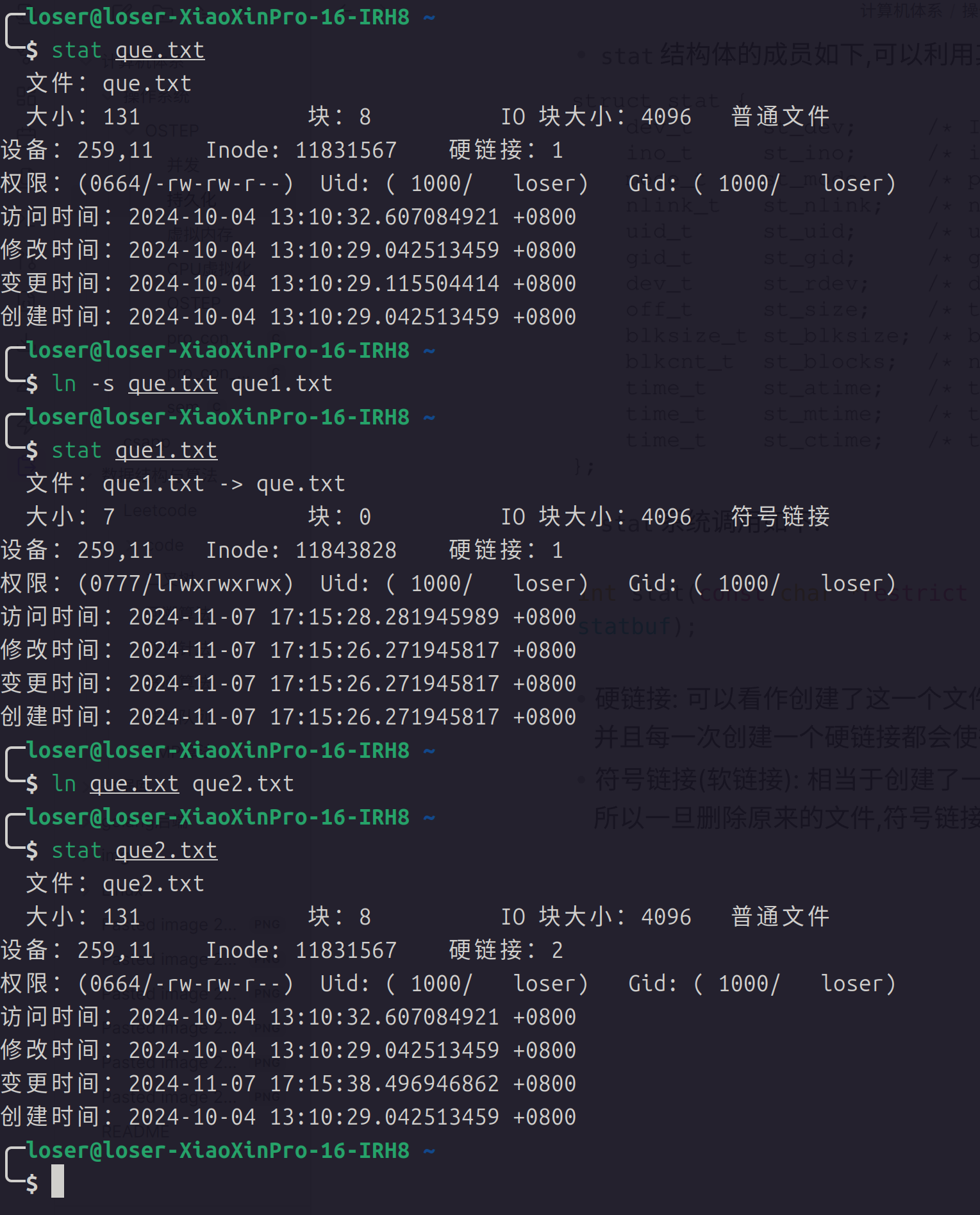

软连接和硬连接

- 创建软连接(相当于快捷方式):

ln -s file file.s - 注意此时创建的快捷方式占用的空间大小就是文件名称的大小,实际上访问快捷方式就是访问了关联的文件名称(当成快捷方式看待)

- 为了保证软连接可以任意移动,创建时需要使用绝对路径

- 注意文件权限和软连接的权限(软连接的权限全部开发只是表示软连接本生的读写权限,并且和原始文件无关)

- 硬连接: 注意硬连接和软连接的区别就是硬连接和原始的文件执行同一个数据空间,所以更改任何一个硬连接的内容,原始的内容也会发生改变

- 注意目录不可以创建硬连接

- 硬连接记数:

- 每创建一个硬连接,硬连接技术都会发生改变,当硬连接技术减少为

0的时候,就会删除文件

- 每创建一个硬连接,硬连接技术都会发生改变,当硬连接技术减少为

- 实现方式:

- 各种文件会在一个棵树(节点使用

Inode表示,硬连接都有一个相同的Inode) - 删除的时候,只将硬连接记数减少,当记数减少为

0的时候才会完全删除

- 各种文件会在一个棵树(节点使用

- 可以使用

stat命令查看Inode

创建和修改用户组

whoami查看当前用户chmod [who] [+][-] [mode] 文件名a表示所有人u表示文件所有者(第一个位置)o表示其他人g表示给第二个位置修改权限

- 文件权限修饰:

- 首位表示文件类型

- 之后表示所有者的权限

- 表示用户组的权限

- 表示其他人的权限

- 数组设定法:

r4w2x1

- 比如设置:

chomod 471 文件,结果如下:- -r--rwx--x

chown命令用户修改文件所有者,当创建一个文件的时候,这一个文件属于用户和文件所有者,所以chown可以修改用户组和用户:chown 用户名/用户组 文件名

- 注意修改之后,所有者就会发生改变,所以利用

chmod的时候一定需要注意 adduser表示创建用户:sudo adduser 用户名

addgroup表示添加用户组:sudo addgroup 用户组

chgrp表示修饰文件所有的用户组:chgrp 用户组 文件名

- 或者直接使用

chown 用户:用户组 文件就可以直接设置,创建用户的同时会创建一个同名的用户组 - 删除用户:

deluser:deluser 用户

- 删除用户组:

delgroup:delgroup 用户组名

find命令

find使用方式:find 查找目录 [options] 类型(名称)

options:-type表示文件类型-name表示文件名称-size表示按照文件大小查找-atime(最近访问时间),-mtime(修改时间),-ctime(修改时间)表示按照时间进行修改

- 还可以指定搜索深度(

-maxdepth n表示最大递归深度) - 例如:

# 表示 > 20M < 50M

$ find ~ -size +20M -size -50M

# 表示一天以内修改了

$ find ~ -ctime 1

# 找到的结果交给某一个命令执行

$ find /usr/ -name "*.tmp" -exec ls -l {}\

# 表示执行某一个命令(交互模式)

$ find /usr/ -name "*.tmp" -ok rm -r {}\

- 如果不使用

-size就默认按照块搜索,传统的磁盘的最小计量单位512B,最小的就是512B - 重点掌握参数,可以使用

man find查看帮助文档 grep以文件内容作为搜索对象:

# 表示递归搜索文件夹(按照文件名称搜索)

$ grep -r D 目录名

# 用途搜索指定的进程或者搜索文件名称

$ ps aux | grep bash

# 一般就是结合管道使用

xargs和exec的区别(都是类似于管道的功能):xargs当搜索结果集的大小比较大的时候,那么就会分片执行(执行效率比较高)exec直接执行所有结果集

# 表示打印的结果使用 null 作为结果

$ find ./ -maxdepth 1 -type f -print0 | xargs -print0 ls -l

- 其实搜索到的结果就是一个集合,可以结合管道结合

xargs命令使用,提高效率 - 当文件名中间有空格的时候,比如文件名为:

abc xyz的时候,如果直接使用xargs就会导致解析成两个文件,所以可以使用find的-print0参数(表示每一个结果使用null进行分割)

$ find ./ -size +20k -21k -print0 | xargs -0 ls -l

sed会按照行进行拆分,利用awk会按照列进行拆分

软件的卸载和安装

apt相当于是apt-get的子集,并且比apt更新,推荐使用aptapt换源方式: https://blog.csdn.net/weixin_65451201/article/details/135198265sudo apt update更新软件库sudo apt remove卸载软件sudo apt upgrade升级软件包deb包的安装:sudo dpkg -i xxx.deb安装deb软件包sudo dpkg -r xxx.deb删除deb软件包sudo dpkg -r --purge xxx.deb连同配置文件一起删除sudo dpkg -info xxx.deb查看软件包的信息sudo dpkg -L xxx.deb查看文件拷贝详细命令sudo dpkg -l查看系统中已经安装软件报的信息命令sudo dpkg-reconfigure xxx重新配置软件包命令

- 源代码安装:

- 解压

cd dir./configuremake(编译源码)sudo make install(把库和可执行文件安装到系统路径下)sudo make distclean(删除和卸载软件)

- 压缩包安装:

- 首先解压

- 之后移动到

/usr/local中 - 之后启动脚本文件即可

压缩和解压

- 压缩:

tar -zcvf 需要生成的压缩包 压缩材料,例如:tar -zcvf test.tar.gz file1 dir2

gzip命令用于压缩文件:gzip file,但是弊端就是只可以压缩一个文件,不可以压缩多个文件或者文件夹tar -zcvf中:z表示压缩c表示创建v表示显示压缩过程f表示文件- 创建压缩文件

bzip2命令,bzip2 文件- 所以总结一下解压和压缩的命令:

tar -zcvf 目标文件名 文件表示使用gzip 压缩后缀:.tar.gztar -jcvf 目标文件名 文件使用bzip2进行压缩,后缀也是一样

- 解压缩

tar -zxvf test.tar.gz表示使用gunzip解压tar -jxvf test.tar.gz表示使用bzip2解压

-C表示解压到那一个文件中rar压缩:rar a -r newdir dir表示递归压缩,默认后缀就是.rarunrar x Xxx.rar解压命令

zip压缩 :- 压缩:

zip -r dir.zip dir - 解压:

unzip dir.zip

- 压缩:

- 总结:

linux中解压工具有gzip和bzip2,但是他们都只可以压缩单个文件,所以需要使用tar -zcvf -jcvf -zxvf -jxvf代替- 同时也可以利用

rar和zip工具进行linux下工具的打包

cat &表示后台运行catjobs可以查看后台的作业fg表示切换到前台bg表示切换到后台env表示查看环境变量passwd 用户名表示修改密码ifconfig用于查看当前的ip地址man查看帮助手册:- 第一章节命令

- 第二章: C lib库

man n 命令可以查看某一个命令在某一章的介绍alias表示起别名l$ alias pg='ps aux | grep bash'umask 权限表示掩码,比如664 使用 777 减去就是 113,去掉执行权限之后就是002- 比如

umask 522得到的掩码就是777 - 522 - 111,创建的权限显示之后就可以得到掩码值 - 创建终端:

ctrl + alt + t新建终端ctrl + shfit + t拆分终端

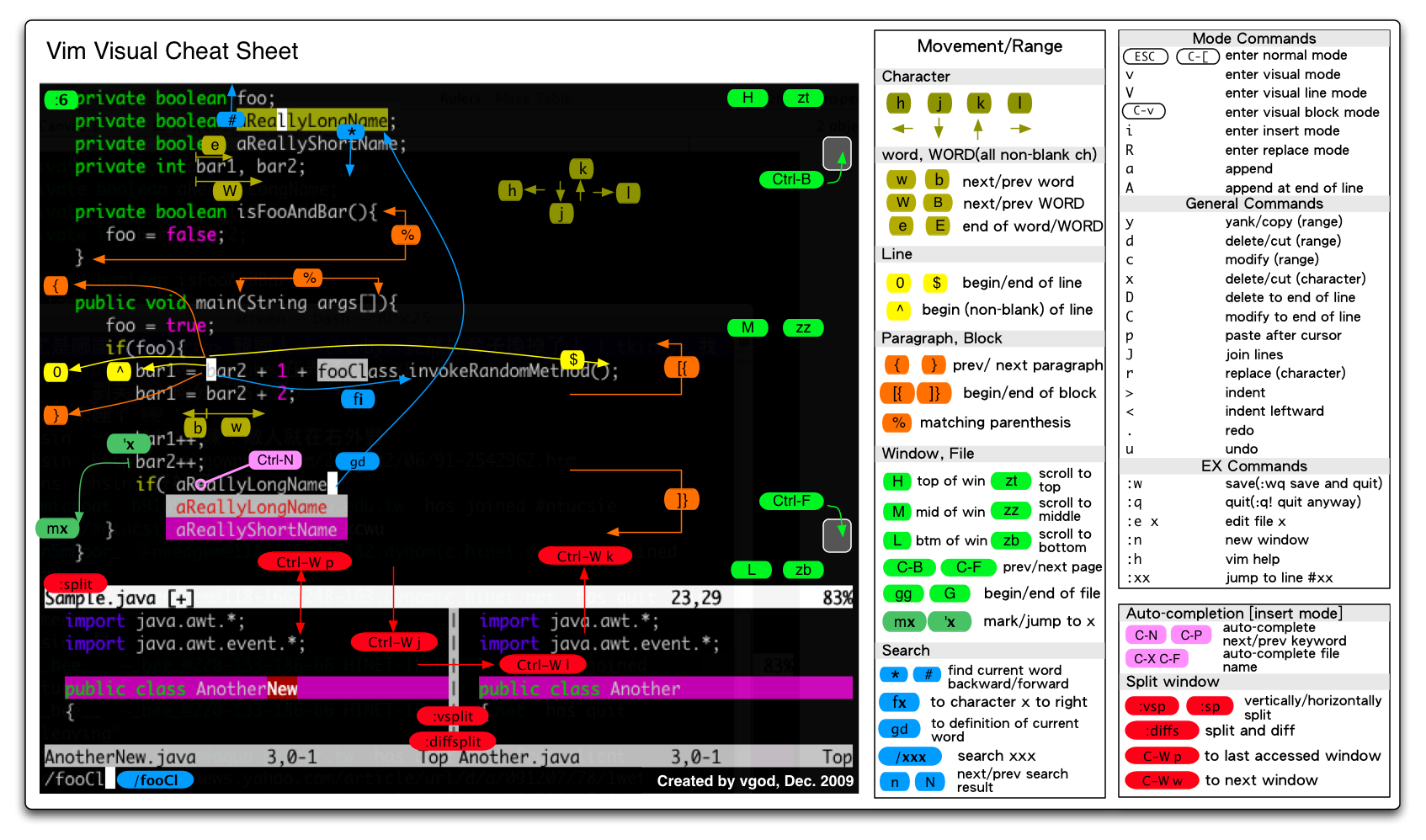

vim 的基本使用方式

三种工作模式

- 命令模式:

i a o I A O s S进入文本模式,:进入末行模式 - 文本模式

esc进入命令模式 - 末行模式: 可以输入各种命令,按下两次

esc键两次也可以回到末行模式 - 不用

vim了,用不来

Shell编程

Shell介绍

linux通过内核操作计算机硬件,内存,磁盘,显示器等- 通过编写

Shell命令发送给linux内核去执行,操作的就是计算机硬件,所以Shell命令是用户操作计算机硬件的桥梁 Shell是一门程序程序设计语言,含有变量,流程控制语句等Shell就是通过shell命令编写的shell文本文件,也就是shell脚本shell脚本 -->shell解析器 --> 内核 ---> 响应- 支持的

shell解析器如下,一般使用bash - 利用

$SHELL可以查看默认的shell解析器,$SHELL是全局环境变量,所有shell程序都可以访问的

Shell入门

- 后缀名:

.sh - 首行需要时设置:

#!/bin/bash表示采用bash解析 - 注释格式:

#多行::<<! # 内容1 # 内容2 ! - 执行方式:

sh解析器执行方式sh Xxx.shbash解析器解析方式bash Xxx.sh- 仅路径执行方式

./Xxx.sh需要权限

环境变量

-

系统环境变量: 是系统提供的共享变量,是

linux系统加载shell配置文件中定义的变量共享给所有的shell程序使用:- 全局配置文件

/etc/profile/etc/profile.d/*.sh/etc/bashrc

- 个人配置文件:

- /.bash_profile

- /.bashrc

- 全局配置文件

-

用户级环境变量:

Shell加载个人配置文件,共享给当前当前用户的Shell程序使用 -

自定义变量:

-

特殊符号变量:

-

可以使用

set变量查看所有函数和系统变量 -

常用的环境变量:

PATH设置命令的搜索路径,使用 : 分割HISTFILE表示命令列表SHELL当前解析器LANG表示使用的字符编码方式

-

env用户查看系统环境变量set还会查看自定义变量和函数

自定义变量

- 自定义局部变量(定义在一个脚本文件中的变量只能在这一个脚本文件中使用的变量)

变量名=变量值注意没有空格,不可以使用关键字作为变量名称 - 自定义常量: 设置值之后就不可以修改了

readonly 变量名=变量值 - 自定义全局变量

- 查询变量的值:

$变量名${变量名}适合拼接字符串

- 删除变量:

unset 变量名

父子Shell环境介绍

- 如果在

A.sh中执行了B.sh那么A.sh就是父Shell环境,B.sh就是子Shell环境 - 如果在

A.sh中定义全局变量,B.sh中也可以使用 - 定义全局变量的方式:

export var_name1 var_name2

- 删除还是使用

unset

特殊符号变量

$n: 用于接受脚本文件传入的参数$1 - $9表示获取第n个参数 或者${数字},$0表示脚本名称$#表示获取所有输入参数的个数$@表示获取所有输入参数的个数,不使用 双引号括起来功能一样"$*"获取所有参数拼接的一个字符串"$@"表示获取一组参数列表对象,利用循环打印所有输入参数$?用于获取上一个Shell命令的退出状态码,或者函数的返回值$$获取当前进程环境的ID

自定义系统环境变量

- 主要编辑

/etc/profile其中就是系统级别的环境变量,当用户进入系统环境初始化的时候,会加载/etc/profle中的环境变量,提供给所有的shell程序使用,只要是所有的Shell程序使用的全局变量都可以定义在这一个文件中 - 创建步骤:

- 增加变量

# 增加命令:

定义变量VAR1=VAR1

并且倒入为环境变量

export VAR1=VAR1

- 重载环境变量

source /etc/profile

vim中使用G定位到文件末尾gg定位到首行位置

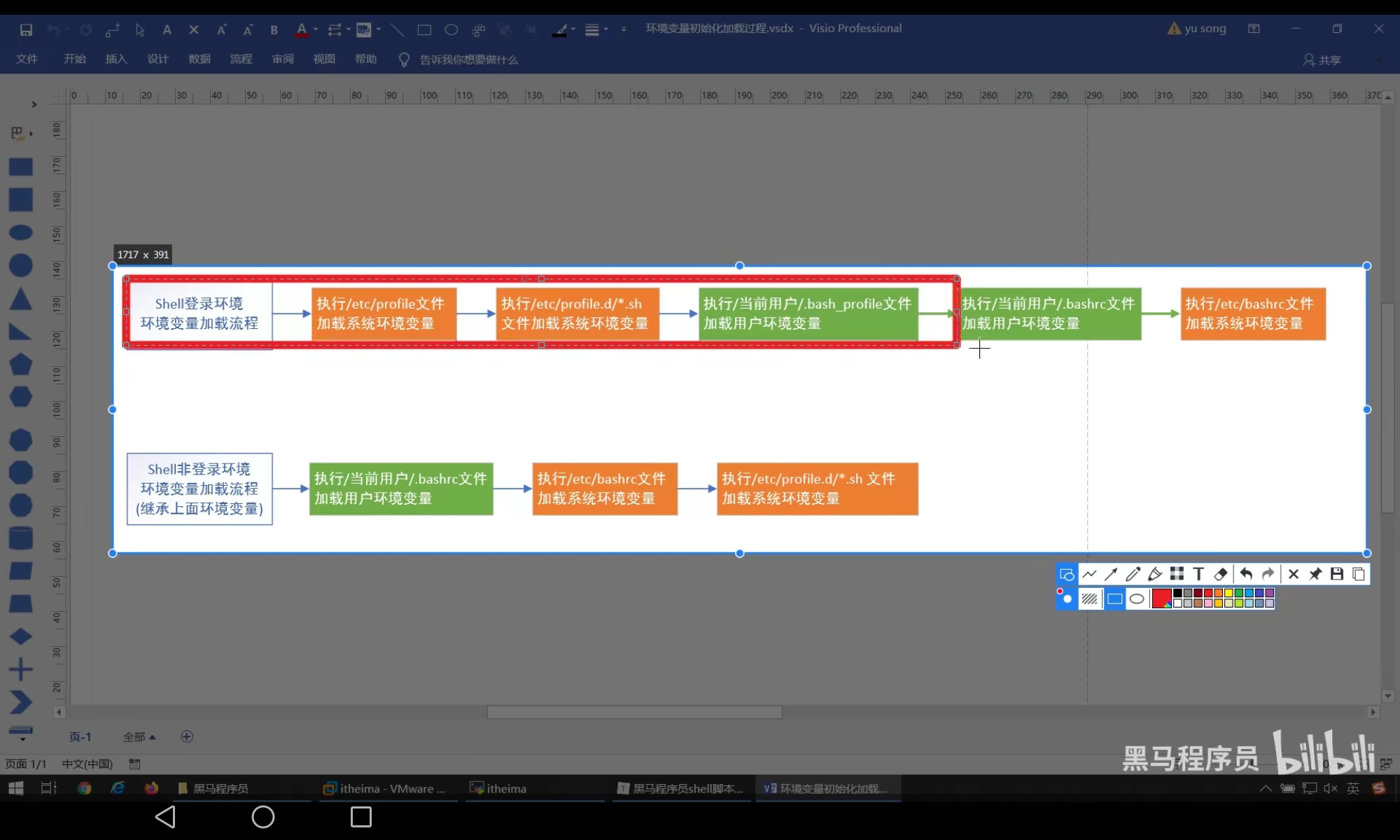

加载流程原理

Shell工作环境: 用户进入linux系统就会初始化shell环境,这一个环境会加载全局配置文件和个人配置文件文件,每一个脚本都有自己的shell环境- 交互式: 与用户进行交互,互动,用户输入,

shell就会作出反映 - 非交互式: 不用用户参与就可以执行多个命令

shell登陆环境: 需要用户名/密码登陆的shell环境shell非登陆环境: 不需要用户名,密码进入的shell环境或者执行脚本文件- 环境变量执行过程:

- 可以查看

/etc/passwd查看用户 - 切换

shell环境,可以指定具体shell环境进行执行脚本文件

sh/bash -l/--login # 登陆环境

bash # 加载 shell 份非登陆环境

sh/bash 脚本文件 # 之间执行脚本文件

- 需要登陆的写在

/etc/profile里面,否则可以写在 ~/.bashrc - 识别

shell环境的命令:echo $0:-bash表示登陆环境bash表示非登陆环境

字符串变量

- 定义方式:

- 单引号(原样输出)

- 双引号

- 不使用引号方式

- 单引号无法解析

${},但是双引号无法解析 - 可以使用 \ 进行转义字符

- 字符串拼接:

- 没有符号拼接

- 双引号拼接

- 混合拼接

字符串截取

- 字符串截取方式:

${变量名:start:length}${变量名:start}${变量名:0-start:length},表示从右边开始截取${变量名#*chars}截取左边出现的某个第一次出现的字符的右边的所有字符${变量名##*chars}截取从右边第一个出现指定的佐夫的右边的所有字符${变量名%chars*}表示按照右边查找第一个截取左边${变量名%%chars*}表示按照右边查找最后一个字符截取左边的

Shell索引数组变量

- 语法:

array_name=(item1 item2) # 方式1

array_name([索引下标1]=item1 [索引下标]=item2)

- 数据类型可以不同,但是注意初始了多少个索引就说明长度为多少

- 获取元素

${arr[index]} - 赋值操作

item=${arr[index]} - 使用

@或者*获取所有元素${arr[@]}arr[*] - 获取指定元素的长度

${#arr[索引]} - 数组的拼接:

arr_new=(${arr1[@/*] ${arr2[@/*]}}) - 删除数组中的元素或者删除整个数组:

unset arr[index]unset arr

shell内置命令

alias设置别名

shell内置命令就是bash自身提供的命令而不是脚本文件type cd就可以查看是否是内其嵌入命令alias命令可以查看所有别名列表- 语法:

alias 别名=命令

unalias别名删除语法:unalias 别名unalias -a删除所有别名

- 内置命令执行速度快,外部脚本文件执行速度慢,执行效率慢

alias lla = "ll -a"

echo命令

echo命令默认换行输出,加上一个参数-n就可以不换行输出- 默认不一会解析换行,但是也可以解析换行,使用

-e表示解析换行符号 - 同时可以配合

\c(用于清除结尾换行符号)

read读取控制台输入

- 语法:

read [-options] [var1,var2 ...]

- 没有设置选项,那么就可以在

REPLY变量中读取到最后一个数据 read 变量名就可以把输入内容输入到变量名中- 选项:

-n num读取num个字符-p prompt显示提示信息-s静默模式-t seconds设置超时时间

- 读取一个字符就可以使用

-n 1就可以了

exit 退出命令

exit用于推出当前shell环境,并且可以返回一个状态码,可以利用$?获取推出状态码- 正确推出状态码:

exit - 错误推出语法:

exit 非0数字 - 可以利用不同的状态定义不同的状态

- 可以使用

$?来确定返回的状态码

declare设置变量

- 可以使用

declared设置变量的属性 - 可以使用

declared查看全部shell变量和函数 - 可以实现索引数组和关联数组赋值

- 语法:

declare [+/-][aArxif][变量名称=设置值]

-

- / - 表示设置或者取消类型

- a array

- A key-value形式的关联容器

- r readonly

- x 设置全局变量

- i 设置整形

- f 设置函数类型

- 关联数组: 键值对数组:

declare -A 关联数组名称=([字符串key]=值1 [字符串key2]=值2)

- 创建所有数组

declare -a 索引数组=(item1 item2)

declare -a 索引数组=([索引1]=value1 [索引2]=value2)

- 获取变量类型一致

运算符

算术运算符

expr命令

- 计算语法:

expr 算术运算符表达式

- 获取计算结果给一个变量:

result=`expr 计算表达式`

- 注意字符之间一定需要空格

expr 1 + 1 - 注意使用

*和()都需要使用\进行转义字符的转义

比较运算符

- 整数比较运算符号:

-eq相等-nq不相等-gt大于-lt小于-ge大于等于-le小于的呢关于><>=<===!=

- 使用方式

[ a -eq -b ],可以使用 $? 查看执行结果 - 使用方式:

(($a>$b)) - 字符串比较运算符号如下: 不成立返回

1否则返回0=或者==表示相等0表示不相等!=<>-z检测字符串长度是否为 0[-z $a],不为空返回1-n检测字符串长度是否不为 0,不为0返回true[ -n "$a" ]$检测是否为空[ $a ]不为空返回0否则返回1

- 使用

[[]]不需要转移,否则就需要转义字符进行转义 - 可以配合

&&和||使用 []和[[]][[]]不会发生分割,[]会发生分割- 就是 "a b" 会被分割

[[]]不需要进行转义,[]不会发生转义

bool运算符

- 如下:

!用于取反-o表示or有一个成立就可以成立[ 表达式1 -o 表达式2 ]-a表示and[ 表达式1 -a 表达式2 ]

逻辑运算符

- 如下:

&&||!

- 使用方式

[[ 表达式1 && 表达式2 ]]

文件测试运算符

- 文件类型:

- 普通文件

- - 目录文件

d - 链接文件

l - 块设备文件

b - 字符设备文件

c

- 普通文件

- 设备文件在

/dev目录下 - 运算符号:

-w是否可以写-r是否可以读-x是否可读-s是否为空-f是否为文件-d是否为目录-e是否存在-nt是否比那一个文件更新

- 使用

[ -w $file_name -a -r $file_name1]

expr命令

- 作用: 表达式求解值(整数计算)

- 字符串操作:

expr length 字符串expr substr 字符串 start end截取expr index 被查找字符串 需要查找的字符查找expr match 字符串 正则表达式(可以自己在网上找到正则表达式)返回匹配的最大长度expr 字符串 : 正则表达式

(()) 命令

- 作用进行整数计算

- 语法:

((表达式)) - 用法:

((b=a-1))a=$((b-1))((a=c-1,b=a+10))echo $((a+10))- ((a>7 && b<8))

- 用于括号内赋值,可以看成

(())就是python运行环境,可以进行多表达式赋值,同时可以结合$进行赋值,也可以进行表达式的操作

let命令

- 语法:

let 赋值表达式

$[]命令

- 作用就是可以进行整数运算,只可以计算结果赋值给变量,但是里面不可以进行赋值运算

bc命令

- 内置的计算器,支持浮点运算,还可以进行进制的转换等操作

- 语法:

bc [options] [参数] - 选项:

-h帮助-v显示版本-lmathlib 使用标准数学库-i强制交互-w显示警告信息-s使用POSIX标准-qquiet不显示欢迎信息

- 同时

bc -q 文件就可以计算文件中的表达式 - 内置变量:

scale指定精度ibase指定输入的数字的进制obase指定输出的数字进制last获取最近计算打印结果的数字

- 内置数学函数:(使用

-l参数)s(x)sinc(x)cosa(x)arctanl(x)log(x)e(x)ej(n,x)贝塞尔函数

- 具体用法:

- 互动式的计算

bc -q进入就可以了 - 使用管道

- 互动式的计算

使用管道进行计算

echo "expression" | bc [options]"expression"必须符合bc命令要求的公式shell中的变量使用$取得- 也可以把

bc变量赋值给 变量

var_name=`echo "expression" | bc [options]`

var_name= $(echo "expression" | bc [options])

非互动式的输重定向运算

- 语法

# 第一种方式

var_name=`bc << EOF`

第一行表达式

第二行表达式

...

EOF

- 作用将多行表达式输入到

bc中

var_name=$(

bc << EOF

表达式1

表达式2

表达式3

...

EOF

)

流程控制语句

if else

if 条件

then

命令

fi

if 命令

then

命令

else

命令

fi

if 条件

then

命令

elif

then

命令

elif

then

命令

else

...

fi

- 条件使用

[[]]或者(())都可以 - 注意

(())中就相当于其他语言运行环境,其中取出变量可以不用使用$ if 表达式; then echo "成立" ;else echo "不成立"; fi;

退出状态

linux命令执行完毕之后都会返回一个退出状态,大多数命令中0表示成功1表示不成功if中使用逻辑连接符号就可以通过返回值判断表达式是否正确

test命令

- 对于整数和字符串和文件的测试

- 语法:

if test 数字1 options 数字2

then

...

fi

options:-eq-ne-gt-lt-ge-le

- 字符串的比较:

=或者==!=\>\<-z 字符串长度为0就是真的-n 字符串字符串的长度不为0就是真

- 文件比较:

- 文件相关的命令

cast 语句

case 值 in

匹配模式1)

命令1

命令2

;;

匹配模式2)

命令1

命令2

;;

..

*)

命令1

命令2

;;

esac

- 只支持如下:

*[abc][m-n]|

case $number in

1)

echo "星期一"

;;

2)

echo "星期二"

;;

3)

echo "星期三"

;;

4)

echo "星期四"

;;

5)

echo "星期五"

;;

6)

echo "星期六"

;;

0|7)

echo "星期日"

;;

*)

echo "数据不合法"

;;

esac

while 语句

- 语法:

while 条件

do

命令1

命令2

...

continue; # 结束当前这一次循环,进入下一次循环

break;

done

- 一行的写法:

while 条件; do 命令; done;

#!/bin/bash

read -p "请输入循环次数" num

count=1

while ((count<=num))

do

if ((count%2==0))

then

echo "${count}是偶数"

else

echo "${count}是奇数"

fi

((count=count+1))

done

until语句

until也是循环语句,但是和while相反,如果条件为false才继续循环- 语法:

until 条件

do

命令

done

- 推荐使用

(())使用[[]]需要使用$

for循环语句

- 语法:

for var in item1 item2 ... itemN

do

命令1

命令2

命令3

...

done

- 一行写法:

for var in item1 item2 ... itemN; do 命令1; 命令2

- 或者范围写法:

for var in {start..end}

do

命令

done

#!/bin/bash

i=0

for i in {1..100}

do

echo "hello,${i}"

done

- 或者第三种方式:

for((i=start;i<=end;i++))

do

命令

done

- 一行写法:

for((i=start;i<=end;i++)); do 命令;done

select 语句

- 用于增强交互性,可以显示带编号的菜单

- 语法:

select var in menu1 menu2 ...

do

命令

done

select是无限循环,输入空值,或者输入的值无效,都不会结束循环,之后只有遇到break或者ctrl + d才会结束循环- 一般可以配合

case使用

#!/bin/bash

echo "请输入你的爱好"

select hobby in "编程" "篮球" "游戏"

do

case $hobby in

"编程")

echo "多敲代码"

break

;;

"篮球")

echo "运动有益于身体健康"

break

;;

"游戏")

echo "少玩游戏"

break

;;

*)

echo "输入有误,重新输入"

;;

esac

done

shell函数

系统函数

- 实现代码复用性

- 常用的系统函数:

basename [string / pathname] [suffix]用于提取文件名称,[suffix]表示曲调文件后缀名称dirname去掉文件名称,只留下目录名称

- 可以使用

declare -f查看所有系统函数

自定义函数

- 语法:

[ function ] funname ()

{

命令

[ reutrn 返回值 ]

}

# 调用函数

funname 参数1 传递参数2 ...

- 可以使用

$?获取返回值

#!/bin/bash

function sum()

{

read -p "请输入第一个数字" first

read -p "请输入第二个数字" second

return $((first + second)) # 表示返回两个数字的和,注意利用 $取出变量

}

sum

echo "返回值为: $?"

- 注意

(())返回的就是一个变量,可以使用$取得他的值

有参函数

$#表示参数个数$*以一个子夫差un显示所有向脚本传递的参数$$脚本运行的当前进程ID$!后台运行的最后一个进程$@和$*相同,但是使用的时候需要加上 引号,并且在引号中返回每一个参数$?显示最后一个命令的退出状态shell命令和函数的区别:shell命令(包含内置命令和外部脚本文件)在子shell中运行,运行时就会开启一个单独的进程- 但是函数在当前的

shell进程中运行

Shell重定向输入输出

重定向

- 标准输入: 从键盘读取用户输入的数据,然后把数据拿到

shell程序中使用 - 标准输出:

shell程序产生的数据,一般显示显示屏上共用户浏览查看 - 每一个

linux命令运行时就会打开三个文件,如下:stdin(标准输入),文件描述符号为0获取键盘上的输入数据stdout(标准输出),文件描述符号为1,将正确的数据输出到显示屏上stderr(输出文件),文件描述符号2,将错误信息将显示器

- 重定向:

- 标准输出表示从键盘输入到程序,输入重定向就是改变了这一个方向

- 标准输入表示从程序输出到显示器,输出重定向就是改变了这一个方向

- 命令如下(

>表示覆盖方式,>>表示追加数据) - 各种命令如下:

| 命令 | 说明 |

|---|---|

| 命令 > file | 将正确的数据输出到file文件中,覆盖方式 |

| 命令 < file | 将输入重定向从file文件中读取数据 |

| 命令 >> file | 将正确的数据重定向输出到file中,追加方式 |

| 命令 < file1 > file2 | 从file1文件中读取数据,输出数据到file2文件中 |

| 命令 fd > file | 将指定文件描述符fd将数据重定向输出到file文件中,覆盖方式 |

| 命令 fd >> file | 根据指定的文件描述符号fd将数据重定向输出到file文件中,追加方式 |

| 命令 fd > file fd1 >& fd2 | 将fd1 和 fd2文件描述符号合并输出到文件中(表示输入到fd1和fd2) |

| fd1 <& fd2 | 将fd1和fd2文件描述符合并从文件读取输入(合并输入) |

| << tag | 读取终端输出数据,将开始标记tag和结束tag之间的内容作为输入,标记名tag可以任意 |

- 例如:

echo "hello" > log.txt

echo "hello world" >> log.txt

ll -afdasfdf 2 > log.txt

ll -afafas >> log.txt 2>&1

echo "hello world" >> log.txt 2>&1 # 表示输入正确信息和错误信息(都可以输出到文件中)

输入重定向

- 可以使用

wc命令进行统计 wc [options] [文件名]options:-c统计字节数量-wword统计单词数量-lline统计行数

wc -l < log.txt

- 循环读取的方式如下:

while read str; do echo "$str" ; done < log.txt

rowno=1;while read str;do echo "第${rowno}行: $str";let rowno++;done < log.txt

- 通过标记读取数据

$ wc -l << EOF

> aaaa

> bbb

> ccc

> ddd

> eee

> EOF

shell中的工具

cut

cut: 用于切割提取指定列\字符\字节的数据- 语法:

cut [options] filename

options选项分析:-f 提取范围列号,获取第几行-d 自定义分割符自定义分割符号,默认就是制表符号-c 提取范围以字符为单位进行分割-b 提取范围以字节为单位进行分割,这些字节将忽略多字节字符边界,除非也制定了-n标志-n和-b选项连续使用,部分个多字节字符

- 范围说明:

n-表示截取n列之后的n - m表示截取n - m列-m表示截取m列之前的列n1 n2 n3表示截取特定的列

# 表示截取第一列和第三列 d 比较重要

cut cut1.txt -d " " -f 1,3

- 按照字符进行截取

echo "helloworld" | cut -nb 1-3

- 切割一行中的数据

$ cat cut1.txt | grep itheima| cut -d " " -f 2

- 同时可以配合

head等命令使用-n表示条数

$ ps aux | grep bash | head -n 1 | cut -d " " -f 7

$ ifconfig | grep inet | head -n 1 | cut -d " " -f 10

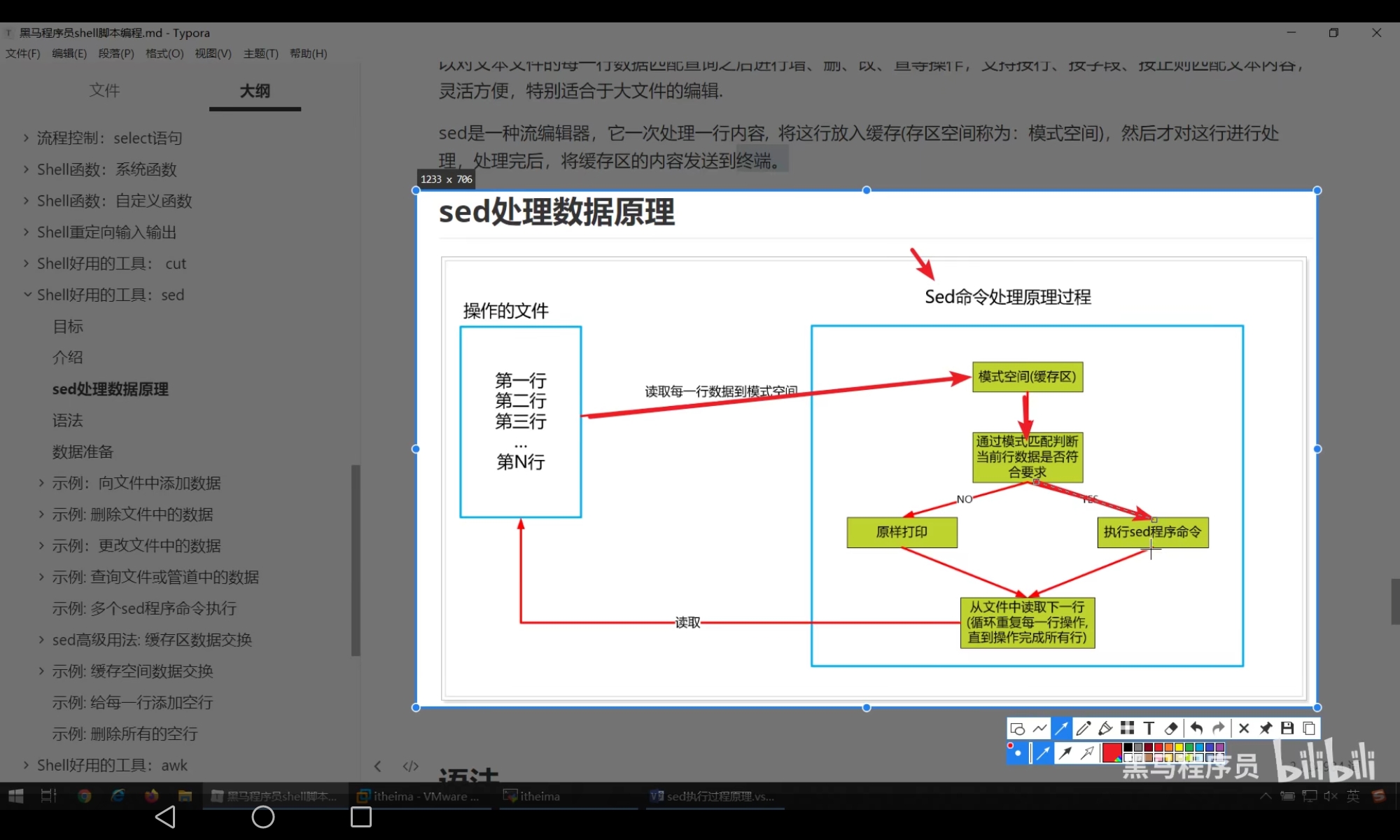

sed

- 一种文件编辑工具:

- 处理流程:

- 语法:

sed [选项参数] [模式匹配/sed程序命令] [文件名]

# 模式匹配,sed会读取每一行数据到模式空间中,之后判断的当前行是否符合模式匹配要求,符合要求就会执行 sed命令,否则就不会执行 sed命令,如果不懈匹配模式,那么每一行都会执行sed程序命令

- 选项参数:

-e直接在指令模式上进行sed动作编辑,他告诉sed下一个参数解释为一个sed指令,只有当命令行上给出多个sed指令才需要使用-e选项,一行命令语句可以指定多个sed命令-i直接对于内容进行修改,不加上-i是默认只是预览,不会对于文件作出实际修改-f后跟上了保存sed指令的文件-n取消默认输出,sed默认会输出所有文本内容,使用-n参数后只会显示处理过的行-r reguler使用拓展正则表达式,默认情况下sed之后识别基本正则表达式*

- 基本命令描述如下:

aadd新增,a的后面可以接上字符串,在下一行出现cchange更改,更改匹配行的内容ddelete删除,删除匹配的内容iinsert插入,向匹配行前面插入内容pprint打印,打印出匹配的内容,通常和-n选项和用ssubstitute替换,替换调匹配的内容=用于打印被匹配的行号n读取下一行,遇到n会自动跳转到下一行

- 特殊符号:

!就像一个sed命令,放在限制条件的后面表示去反{sed命令1;sed命令2}多个命令操作同一个行

- 例如:

- 插入数据

# 基本上就是 `条件 选项 添加字符`的形式

$ sed -i '3ahello' sed.txt

# 表示在第三行的后面加上`hello` `-i`表示修改参数

$ sed '/itheima/ahello' sed.txt

# 表示在 `itheima` 的后面添加数据

$ sed '$ihello' sed.txt

# 表示在最后一行前面添加数据

- 删除文件中的数据

# 删除第二行数据

$ sed '2d' sed.txt

# 删除奇数行 ~表示每隔几行

$ sed '1~2d' sed.txt

# 删除 1 - 3行

$ sed '1,3d' sed.txt

# 取反

$ sed '1,3!d' sed.txt

# 删除最后一行

$ sed '$d' sed.txt

# 删除含有某一行的数据

$ sed '/itheima/d' sed.txt

# 删除匹配和最后一行

$ sed '/itheima/,$d' sed.txt

# 删除匹配和最后一行

$ sed '/itheima/,+1d' sed.txt

# 删除部匹配的行

$ sed '/itheima\|itcast/!d' sed.txt

- 更改文件中的数据

# 包含 itheima 修改为 hello

$ sed '/itheima/chello' sed.txt

# 最后一行修改为 hello

$ sed '$chello' sed.txt

# 替换每行第一个 hello

$ sed 's/itheima/hello/' sed.txt

# 全局匹配替换(一行中所有都会替换)

$ sed 's/itheima/hello/g' sed.txt

# 将每一行中的第二个进行匹配替换

$ sed 's/itheima/hello/2' sed.txt

# 替换之后把内容写入到文件中

$ sed 's/itheima/hello/2w sed2.txt' sed.txt

# 只显示修改的行(p表示显示,n表示匹配)

$ sed -n 's/itheima/hello/2pw sed2.txt' sed.txt

# 正则表达式替换

# // 表示替换成空字符串

$ sed -n '/i/s/t.*//p' sed.txt

# 每一行的末尾拼接 test

$ sed 's/$/& test/' sed.txt

# 每一行行首拼接 #

$ sed 's/^/&#/' sed.txt

- 查询操作

# 查询含有 itcast 的数据

$ sed -n '/itcast/p' sed.txt

# 查询 bash

$ ps aux | sed -n '/bash/p'

- 执行多个命令

# 执行多个shell命令

$ sed -e '1d' -e 's/itheima/itcast/g' sed.txt

# 执行多个shell命令

$ sed '1d;s/itheima/itcast/g' sed.txt

sed高级用法:缓存区数据交换

- 模式空间和暂存空间:

sed命令读出来每一行数据存放的空间叫做模式空间,会在该空间中对于读到的数据作相应处理- 此外

sed还有一个额外的空间就是暂存空间,暂存空间刚开始只有一个空行 sed可以通过相关的命令从模式空间向暂存空间去内容放入到模式空间中

- 命令:

h将模式空间中的内容复制到暂存空间中(覆盖方式)H将模式空间中的内容复制到暂存空间中(追加方式)g将暂存空间中的数据复制到模式空间中(覆盖方式)G将暂存空间中的数据复制到模式空间中(追加方式)x交换两个空间的内容

- 演示

# 将模式空间中的第一行复制到暂存空间(覆盖模式),并且把暂存空间的最后一行复制到模式空间中(追加模式)

$ sed '1h;$G' sed.txt

# 同时删除第一行数据

$ sed '1{h;d};$G' sed.txt

# 第一行的数据赋值粘贴

# 模式空间第一行复制到暂存空间中,最后把暂存空间爱你的内容赋值粘贴从第2行开始到最后一行的数据

$ sed '1h;2,$g' sed.txt

# 将前三行数据复制到暂存空间,之后把暂存空间的所有内容复制到最后一行

$ sed '1,3H;$G' sed.txt

# 暂存空间中有一行空行

# 添加空行,此时会给每一行给一个空行

$ sed 'G' sed.txt

# 删除空行(正则表达式处理)

$ sed '/^$/d' sed.txt

- 暂存空间的作用就是暂存数据进行数据交换

awk

- 一个文本分析工具

- 语法:

awk [options] 'pattern{action}' {filename}

- 选项:

-F指定输入文件拆分分割符号

- 内置变量:

NF浏览记录的域的个数,根据分割符号分割之后的列数量NR已读的记录数量$n表示整条数据$0表示整条记录,$n表示第n个域$NF表示最后一列的信息

- 实例

# 默认按照空格分割数据

$ echo "abc 123 456" | awk '{print $1"&"$2"&"$3}'

# 结果

abc&123&456

# 搜索含有关键字的所有行

$ awk '/root/{print $0}' passwd

# 打印第七列数据

# 注意分割之后还是可以通过 $0 获取到内容

# 注意只有表达式需要 {}

$ awk -F ":" '/root/{print $7}' passwd

# 获取文件名,行号,列号,内容

$ awk -F ":" '{print "文件名:"FILENAME",行号:"NR",烈数:"NF",内容:"$0}' passwd

# 拼接字符串的方式

$ awk -F: '{printf("文件名:%s,行号:%s,列号:%s,内容:%s\n",FILENAME,NR,NF,$0)}' passwd

# 注意内容需要使用 `{}`括号

# 但是 shell 中可以不用使用 () 调用参数即可

# 打印第二行信息

$ awk -F ":" 'NR==2{printf("文件名:%s,内容:%s\n",FILENAME,$0)}' passwd

# c 开头

$ ls -a | awk '/^c/'

# 还可以使用 NF打印最后一列

# 甚至可以写逻辑语句

# 使用多个分割符号进行分割

$ echo "one:two/three" | awk -F "[:/]" '{print $1"&"$2"&"$3}'

# 添加开始和结束

$ echo -e "abc\nabc"| awk 'BEGIN{print "开始 ..."}{print $0}END{print "结束了 ..."}'

# -e 表示处理特殊字符串

# 默认使用空格分割

$ echo "abc itheima itcast" | awk -v str="" '{for(n=1;n<=NF;n++){str=str$n}} END{print str}'

# -v相当于定义变量

# 运算操作

$ echo "2.1" | awk -v i=1 '{print $0+i}'

# 分割操作

$ ifconfig | awk '/broadcast/{print $0}'|head -n 1 | awk '{print $2}'

# 显示行号

$ sed 'G' sed.txt | awk '/^$/{print NR}'

- 总结:

awk在查询数据方面,可以通过条件来进行文本操作,内置多种文本变量,可以通过循环等操作查询到的字符

sort

- 语法:

sort (options) 参数

- 选项:

-nnumber按照数值大小排序-rreverse以相反的顺序来排序-t 分割字符设置排序时使用的分割字符,默认空格就是分割符-k指定需要排列的列2,2表示按照第二列进行排序-d排序时,处理英文字母,数字和空格外,忽略其他字符-f排序时将小写字母视为大写字母-b忽略每一行前面开始出的空格字符-o 输出文件将排序之后的结果存入到指定的文件中-u意味着唯一的(unique),输出的结果时完全去重的-m将几个排序的文件进行合并

- 实例

# 表示分割并且按照第二列排列

$ sort -t " " -k2n,2 sort.txt

# 按照两列去重

$ sort -t " " -k2n,2 -uk1,2 sort.txt

# 保存结果

$ sort -t " " -k2n,2 -uk1,2 -o sort1.txt sort.txt

# 降序排列

$ sort -t " " -k2nr,2 -uk1,2 sort.txt

# 按照多列排序,注意选项含义

$ sort -t "," -k1,1 -k3nr,3 sort.txt

- 使用:

- 字符串升序:

sort -kstart,end 文件 - 字符串降序:

sort -kstartr,end 文件 - 数字升序:

sort -kstartn,end 文件 - 数字下序列

sort -kstarttnr,end文件 - 多列排序:

sort -kstart[nr],end -kstart[nr],end ... 文件

- 字符串升序:

多线程编程

线程概念

Linux下线程的本质:LWP(light weight process) 轻量级的进程,本质仍然是进程(在Linux环境下)- 进程: 有独立的进程地址空间,有独立的

PCB - 线程: 有独立的

PCB,但是没有独立的地址空间(共享) - 区别: 在于是否共享地址空间 独居(进程) 合租(线程)

Linux下:- 线程: 最小的执行单位

- 进程: 最小的分配资源的单位,可以看成只有一个线程的进程

- 当利用

creat函数创建线程之后,进程就会退化成线程 - 所以对于并发执行的进程,如果开启更多的线程,那么就会由更多的线程来抢夺

cpu的执行权利这就使得该进程有更多的机会执行,但是并不是线程越多执行机会越多

- 可以使用

ps -Lf 进程ID来查看进程的线程号(不是线程ID),线程号 -->cpu执行的最小单位

Linux内核线程实现原理

- 注意以下几点:

- 轻量级进程,也有

PCB,创建线程使用的底层函数和进程一样,都是clone - 从内核里面看进程和线程都是一样的,都有各自不同的

PCB,但是PCB中执行内存资源的三级页表是相同的 - 进程可以蜕变成线程

- 线程可以看成寄存器和栈的集合

- 在

linux下,线程是最小的执行单位,进程是最小的分配资源的单位

- 轻量级进程,也有

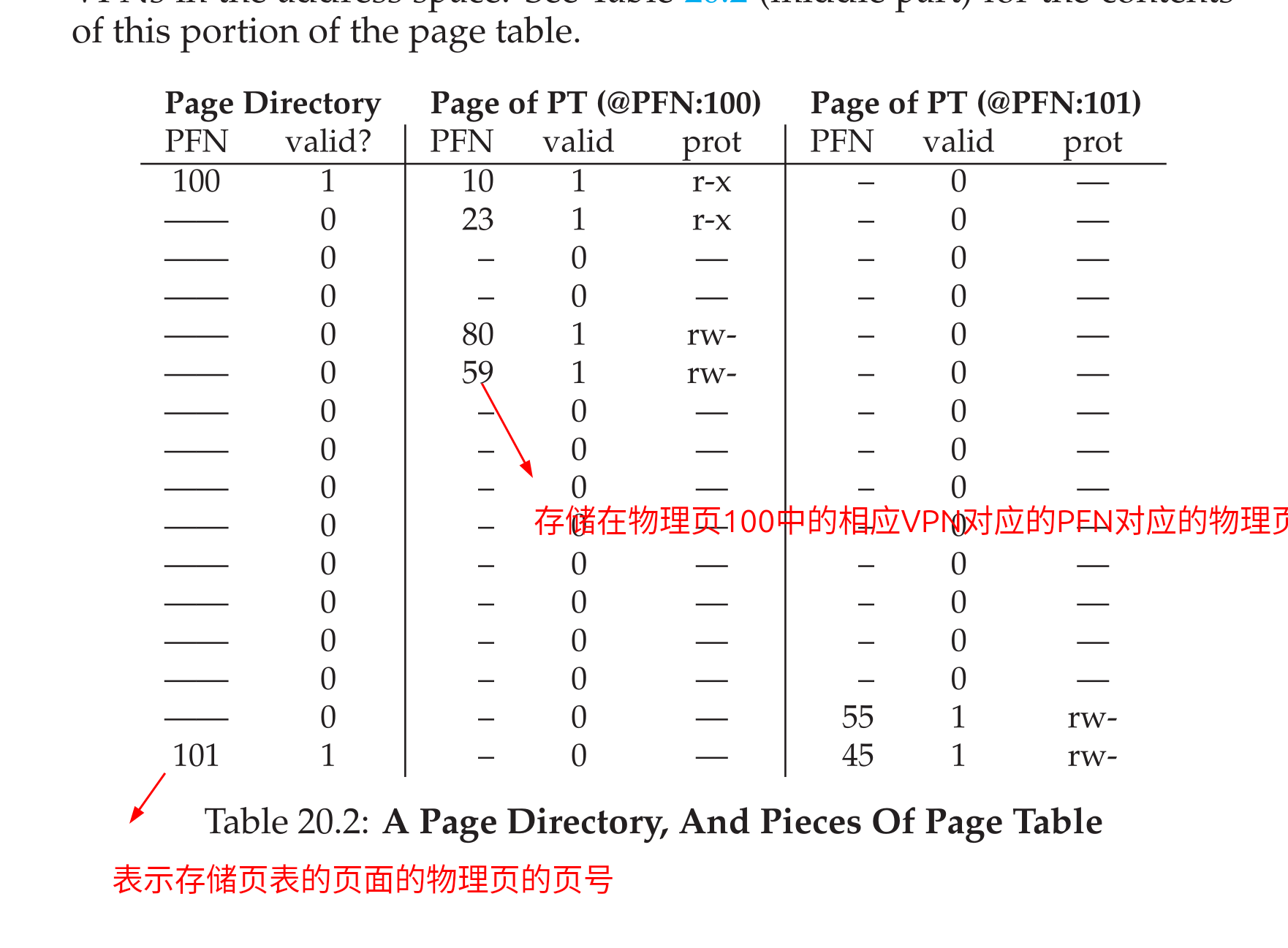

- 实际上,在一个进程中的用户空间中存储的变量并不是直接通过

MMU映射到真实的物理内存空间,而是首先借助PCB中的指针,这一个指针指向一个页目录,页目录中的指针指向页表,页表中的指针指向物理页面,物理页面存在着真实的目录内存,由于创建线程的过程底层其实就是调用了clone方法,所以他的pcb中的指针和原来的进程的pcb中的指针一样,所以指向同样一块内存地址空间 - 三级映射: 进程

PCB--> 页目录(可以看成数组,首地址位于PCB中) --> 页表 --> 物理页面 ---> 内存单元

线程的共享和非共享

- 线程共享资源:

- 文件描述符号表

- 每一种信号的处理方式

- 当前工作目录

- 用户

ID和组ID - 内存地址空间(

.text./data.bssheap共享库)(没有栈)

- 线程非共享资源:

- 线程

id - 处理器线程和栈指针(内核栈)

- 独立的栈空间(用户栈空间)

errorno变量(是一个全局变量)- 信号屏蔽字

- 调度优先级

- 线程

- 优点:

- 提高程序并法性

- 开销比较小

- 数据通信,共享数据方便

- 缺点:

- 库函数,不稳定

- 调试,编写困难,

gdb不支持 - 对于信号支持不好

Linux下实现方法导致进程,线程差别不是特别大

线程控制原语

创建线程

pthread_self函数

- 作用: 获取线程

ID - 头文件:

<pthread.h> - 函数原型:

pthread_t pthread_self(void);

- 返回值: 返回线程

ID - 注意线程

ID用于在一个进程中标记线程,在Linux本质就是lu的别名,其他的系统中使用结构体的方式实现,线程ID是线程内部的识别标志

pthread_create函数

- 作用: 创建新的线程

- 函数原型如下:

int pthread_create(pthread_t *restrict thread,

const pthread_attr_t *restrict attr,

void *(*start_routine)(void *),

void *restrict arg);

- 遍历的时候需要链接

pthread库 - 参数:

thread: 传出参数,作用就是可以带出线程IDattr: 表示设置线程的属性,一般传入NULL表示传入默认属性start_routine: 表示需要传入的执行函数(参数和返回值都是泛型类型)arg: 表示函数的参数

- 演示

demo:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

#include<errno.h>

// 子线程的回调函数

// 注意回调函数的类型 (void*)(*func)(void*)

void* my_func(void* arg)

{

// 获取进程号和线程ID

printf("thread: pid = %d , tid = %lu \n" , getpid() , pthread_self());

return NULL;

}

int main()

{

// 使用 pthread_self 获取线程 ID

pthread_t tid;

tid = pthread_self();

printf("tid = %lu \n" , tid); // 相当于独享进程空间的线程

printf("pid = %d \n" , getpid());

// 使用 pthread_create创建线程

int ret = pthread_create(&tid , NULL , my_func , NULL);

if(ret != 0){

perror("create a thread failed !!! \n");

exit(1);

}

printf("main: pid: %d , tid: %lu \n" , getpid() , pthread_self());

// 需要让主线程阻塞等待一段时间

sleep(1);

}

-

注意得到的结果中,

main和pthread的pid一样但是tid不一样 -

由于需要传入的函数必须是

void*(*func)(void*)类型,所以如果需要传入各种参数那么就需要定义结构体来作为传入参数,函数会被自动调用

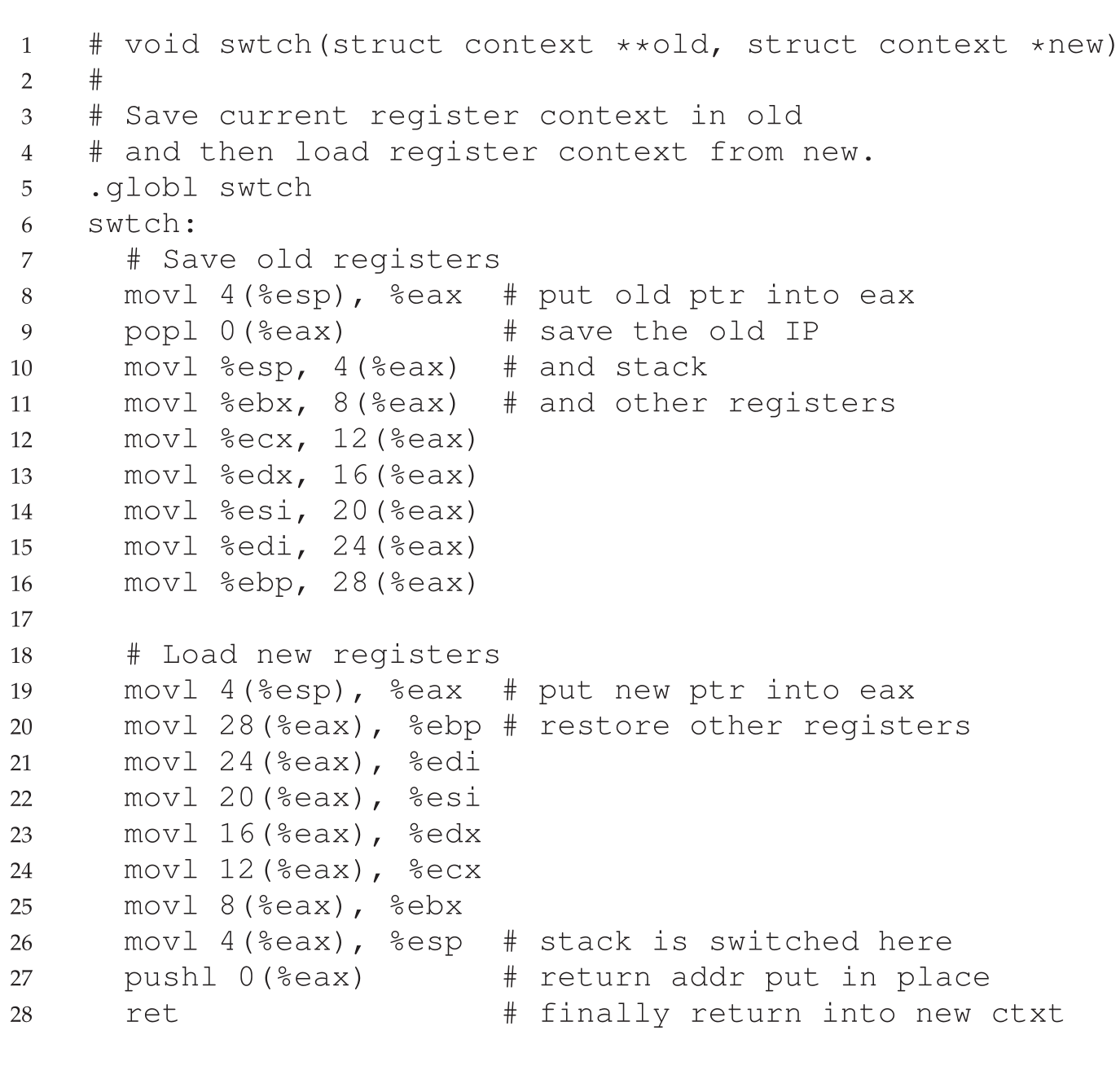

循环创建子线程

- 如果使用以下代码循环创建子线程:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

// 回调函数

void* print_pthread(void* args)

{

int i = *((int*)args); // void* 类型相当于泛型,可以传递各种类型

printf("pthread %d: pid - %d , tid - %lu \n" , i + 1, getpid() , pthread_self());

return NULL;

}

int main()

{

// 循环创建多个子线程

pthread_t tid;

int ret , i;

for(i = 0 ; i < 5 ; i ++){

ret = pthread_create(&tid , NULL , print_pthread , (void*)&i);

if(ret != 0){

perror("create thread failed !!! \n");

exit(1);

}

}

printf("main: pid - %d , tid - %lu \n" , getpid() , pthread_self());

sleep(1);

}

- 就会发生如下结果:

pthread 4: pid - 88902 , tid - 124829323757248

pthread 5: pid - 88902 , tid - 124829334243008

pthread 5: pid - 88902 , tid - 124829313271488

pthread 5: pid - 88902 , tid - 124829302785728

main: pid - 88902 , tid - 124829340292928

pthread 6: pid - 88902 , tid - 124829292299968

- 错误原因分析: 以上代码中,由于

main函数和不同的线程有不同的栈帧,main函数的栈帧中存在变量i,如果使用地址传递的方式传递参数,就会导致此时线程的栈中的变量指向main函数的栈中的变量,但是main函数中的变量在不断变化,所以就会造成以上结果 - 所以最好在创建子线程的时候,使用值拷贝的方式传递参数

- 这里的

void*尽管可以当成一个可以转换为任意数据类型的泛型(类似于go中的空接口类型),void*占用8个字节,int占用4个字节所以转换的时候不会造成精度的缺失 - 各种类型占用的空间如下,注意指针占用

8个字节(64位编译器):

- 这里解释以下为什么说

64位操作系统中int占用8个字节:- 注意这里的

int并不是指的就是int,而是int类型的变量,比如long等,long在32位操作系统中占用4个字节但是在64位操作系统中占用8个字节,位数不同的操作系统的寻址能力不同,体现与指针的位数,比如64位操作系统中的寻址范围就是 $2^64$ 所以指针就占用8个字节也就是64个bit

- 注意这里的

- 正确代码如下:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

// 回调函数

void* print_pthread(void* args)

{

int i = (int)args; // void* 类型相当于泛型,可以传递各种类型

printf("pthread %d: pid - %d , tid - %lu \n" , i + 1, getpid() , pthread_self());

return NULL;

}

int main()

{

// 循环创建多个子线程

pthread_t tid;

int ret , i;

for(i = 0 ; i < 5 ; i ++){

ret = pthread_create(&tid , NULL , print_pthread , (void*)i);

if(ret != 0){

perror("create thread failed !!! \n");

exit(1);

}

}

printf("main: pid - %d , tid - %lu \n" , getpid() , pthread_self());

sleep(1);

}

线程和共享

- 线程之间共享全局变量

- 线程默认共享数据段,代码段的呢个地址空间,常用的就是全局变量,但是进程不会共享全局变量,只可以借助

mmap(进程中遵循读时共享,写时复制的原则,其实就是建立了副本)

- 线程默认共享数据段,代码段的呢个地址空间,常用的就是全局变量,但是进程不会共享全局变量,只可以借助

- 注意共享的含义就是子线程改变变量,父线程中的数据也会进行相同的改变

- 验证:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

int var = 20;

void* pthread_handler(void* arg)

{

var = 200;

printf("thread: var = %d \n" , var);

return NULL;

}

int main()

{

pthread_t tid ;

int ret;

ret = pthread_create(&tid , NULL , pthread_handler , NULL);

if(ret != 0){

perror("creat thread failed !!! \n");

exit(1);

}

sleep(1);

printf("main: var = %d \n" , var);

}

- 注意

C语言中各个内存区域和作用:

pthread_exit函数

- 作用: 线程退出

- 函数原型:

[[noreturn]] void pthread_exit(void *retval);

- 参数:

retval表示传出参数,用于承载子线程中返回值 - 为什么使用

pthread_exit,这是由于exit用于退出整个进程,而不是退出线程,return表示返回给函数调用者 - 利用

pthread_exit退出只是将线程退出,并且不会影响其他进程 - 各种退出效果总结如下:

return返回到调用者那里去pthread_exit将调用该函数的线程退出exit退出它的进程

- 三者的对比如下:

#include<stdio.h>

#include<stdlib.h>

#include<pthread.h>

#include<unistd.h>

// 演示 return exit pthread_exit 三者之间的区别

void* pthread_handler(void* arg)

{

int i = (int)arg;

if(i == 2){

// exit(0); // 表示退出当前进程

// return NULL; 返回给函数的调用这

pthread_exit(NULL); // 表示退出线程

}

printf("The %d th thread , tid: %ld \n" , i + 1 , pthread_self());

return NULL;

}

int main()

{

pthread_t tid;

int ret;

int i;

for(i = 0 ; i < 5 ; i ++){

ret = pthread_create(&tid , NULL , pthread_handler , (void*)i);

if(ret != 0){

perror("create thread failed !!! \n");

exit(1);

}

}

// sleep(1);

pthread_exit(NULL); // 表示退出父进程

}

pthread_join函数

- 作用: 阻塞等待线程退出,获取线程退出状态,其作用就是对应于进程中的

waitpid()函数 - 函数原型:

int pthread_join(pthread_t thread, void **retval);

- 参数:

thread表示需要回收的线程IDretval表示获取函数的退出状态(需要回收void*)(比如进程的退出值就是pid)(注意这里的设计逻辑,如果返回值是int类型,那么就需要使用int*类型回收返回值,如果返回值是void*类型,那么就需要使用void**回收返回值)(参考wait函数使用&status作为传出参数)

- 注意

pthread_join会阻塞等待 - 另外一个小的知识点,注意指针只有分配了内存空间才可以使用常量赋值,但是如果没有分配内存空间还是可以使用指针或者地址赋值

char* p = NULL;

p = "123";// error

char* p = (char*)malloc(sizeof(char) * 10);

p = "hello"; //正确

int* p;

int k = 1;

p = &k // 正确

pthread_join使用方式如下:

#include<stdio.h>

#include<stdlib.h>

#include<pthread.h>

#include<unistd.h>

#include<string.h>

// 用于传递的数据

struct thrd{

int var;

char name[256];

};

void* thread_handler(void* arg)

{

struct thrd* ret_val;

ret_val = (struct thrd*) malloc (sizeof(struct thrd));

ret_val -> var = 100;

// 注意常量无法使用 = 进行赋值操作

strcpy(ret_val -> name , "hello thread!!!");

return (void*)ret_val;

}

int main()

{

pthread_t tid;

int ret;

ret = pthread_create(&tid , NULL , thread_handler , NULL);

if(ret != 0){

perror("create thread failed !!! ");

exit(1);

}

// 进行回收

struct thrd* res;

ret = pthread_join(tid , (void**)&res); // 注意参数

if(ret != 0){

perror("resouce my child failed !!!");

exit(0);

}

// 打印数据

printf("var = %d , name = %s \n" , res -> var , res -> name);

pthread_exit(NULL);

}

- 需要注意的事项如下:

- 在线程执行的函数中,不要返回一个局部变量的地址(此时这个函数的栈帧已经被销毁了,返回一个没有意义的栈地址)

- 可以在

main函数中定义一个变量,之后在线程的执行函数中操作这一个变量,这是由于函数执行完了之后main函数的栈地址仍然存在依然可用

- 以下情况也正确但是还是最好在堆区开启空间:

- 可以返回局部变量的值,但是不可以返回局部变量的地址

#include<stdio.h>

#include<stdlib.h>

#include<pthread.h>

#include<unistd.h>

#include<string.h>

// 用于传递的数据

struct thrd{

int var;

char name[256];

};

void* thread_handler(void* arg)

{

struct thrd* ret_val = (struct thrd*) arg;

// ret_val = (struct thrd*) malloc (sizeof(struct thrd));

ret_val -> var = 100;

// 注意常量无法使用 = 进行赋值操作

strcpy(ret_val -> name , "hello thread!!!");

return (void*)ret_val;

}

// void* thread_handler(void* arg)

// {

// return (void*)100;

// }

int main()

{

pthread_t tid;

int ret;

struct thrd* arg;

ret = pthread_create(&tid , NULL , thread_handler , (void*)arg);

if(ret != 0){

perror("create thread failed !!! ");

exit(1);

}

// 进行回收

struct thrd* res;

// int res;

ret = pthread_join(tid , (void**)&res); // 注意参数

if(ret != 0){

perror("resouce my child failed !!!");

exit(0);

}

// 打印数据

printf("var = %d , name = %s \n" , res -> var , res -> name);

printf("var = %d , name = %s \n" , arg -> var , arg -> name);

// printf("var = %d \n" , res);

pthread_exit(NULL);

}

- 连续: 循环创建多个子线程并且回收:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<string.h>

#include<pthread.h>

void* thread_handler(void* arg)

{

int i = (int)arg;

printf("I am the %d th child , my tid is %ld \n" , i + 1, pthread_self());

return NULL;

}

int main()

{

// 循环创建多个子线程

pthread_t tid[5];

int ret;

for(int i = 0 ; i < 5 ; i ++){

ret = pthread_create(&tid[i] , NULL , thread_handler , (void*)i);

if(ret != 0){

perror("create thread failed !!! ");

exit(1);

}

}

// 循环退出

for(int i = 0 ; i < 5 ; i ++){

ret = pthread_join(tid[i] , NULL);

printf("Successfully resource my child: %d \n" , i + 1);

}

pthread_exit(NULL);

}

pthread_cancel函数

- 作用: 用于杀死线程

- 函数原型如下:

int pthread_cancel(pthread_t thread);

- 参数:

thread表示需要杀死的进程ID

- 注意利用

pthread_cancel把进程杀死的时候 - 注意利用

pthread_cancel杀死进程的时候进入内核,需要进入内核的契机,如果子进程一直执行就没有取消点了,如果没有保存点,那么就可以使用pthread_testcancel()来设置取消点 - 成功被

pthread_cancel杀死的线程,返回-1,可以使用pthread_join回收这一个值 - 演示

demo如下:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

#include<string.h>

void* thread_handler(void* arg)

{

while(1){

// printf("I am the child , tid : %ld \n" , pthread_self());

// sleep(1);

pthread_testcancel();

}

return (void*)100;

}

int main()

{

// 利用 pthread_cancel 杀死线程

pthread_t tid;

int ret = pthread_create(&tid , NULL , thread_handler , NULL);

sleep(5);

// 杀死线程

ret = pthread_cancel(tid);

if(ret != 0){

perror("can not canel this thread !!!");

exit(1);

}

// 进行线程的回收

int res;

ret = pthread_join(tid , (void**)&res);

if(ret != 0){

perror("resource thread failed !!!");

exit(1);

}

printf("exit code is %d \n" , res);

}

pthread_detach函数

- 作用: 实现线程分离,让线程脱离与主线程而存在

- 函数原型如下:

int pthread_detach(pthread_t thread);

- 参数:

- 线程号

- 对于线程中出现的错误,不可以使用

perror进行打印,这是由于无法翻译错误条件,可以使用strerror(errno)结合fprintf进行错误处理即可 - 注意即检测出错返回的方式 !!!

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

#include<string.h>

// 创建子线程任务

void* thread_handler(void* arg)

{

while(1){

printf("[thread] pid : %ld \n" , pthread_self());

sleep(1);

}

return NULL;

}

int main()

{

// 创建

pthread_t tid;

int ret = pthread_create(&tid , NULL , thread_handler , NULL);

if(ret == -1){

// 注意错误处理方式

fprintf(stderr , "create thread failed: %s \n" , strerror(ret));

exit(1);

}

sleep(1);

ret = pthread_detach(tid);

if(ret != 0){

fprintf(stderr , "detach thread failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_join(tid , NULL);

if(ret != 0){

// perror("resource thread failed !!!");

fprintf(stderr , "resource thread failed: %s \n" , strerror(ret));

exit(1);

}

}

进程控制原语和线程控制原语的区别

- 创建:

forkpthread_create - 回收:

wait waitpidpthread_join - 杀死:

killpthread_cancel - 获取信息:

getpid()pthread_self - 退出:

pthread_exitexit

线程属性设置分离线程

- 线程属性就是创建线程时候的第二个参数

- 早期的

Linux kernel中的线程状态结构体:

typedef struct {

int etachstate; // 线程的分离状态

int schedpolicy; // 线程调度策略

struct sched_param schedparam; // 线程的调度参数

int inheritsched; // 线程的继承性

int scope; // 线程的作用域

size_t guardsize; // 线程栈末尾的警戒缓冲区大小

int stackaddr_set; // 线程栈的设置

void* stackaddr; // 线程栈的位置

size_t stacksize; // 线程栈的大小

}pthread_attr_t;

设置线程的分离状态

- 注意设置线程分离状态的好处: 不用回收线程,线程执行完之后自动就可以被回收了

- 线程属性初始化,使用如下两个函数:

pthread_attr_init用于初始化线程属性pthread_attr_destory销毁线程属性所占用的资源- 注意这两个函数的作用就是操作线程属性而不是操作线程

int pthread_attr_init(pthread_attr_t *attr);

int pthread_attr_destroy(pthread_attr_t *attr);

分离状态以及非分离状态

- 非分离状态: 线程默认的属性就是非分离状态,这一种情况下,原有的线程等待创建的线程结束,只有当

pthread_join函数返回的时候,创建的线程才算终止,才可以释放自己占用的系统资源 - 分离状态: 分离线程没有被其他的线程等待,自己运行结束了,线程也终止了,马上释放系统资源,应该根据自己的需要,选择适当的分离状态

- 设置线程分离的函数:

pthread_attr_setdetachstate - 查看线程分离状态的函数:

pthread_attr_getdetachstate - 参数(detachstate):

PTHREAD_CREATE_DETACHED(分离线程)PTHREAD_CREATE_JOINABLE(非分离线程)

int pthread_attr_setdetachstate(pthread_attr_t *attr, int detachstate);

int pthread_attr_getdetachstate(const pthread_attr_t *attr,

int *detachstate);

- 演示

demo如下:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

#include<errno.h>

#include<string.h>

void* thread_handler(void* arg)

{

while(1){

printf("[thread] pid : %ld \n " , pthread_self());

sleep(1);

}

return (void*)100;

}

int main()

{

pthread_attr_t attr;

int ret = pthread_attr_init(&attr);

if(ret != 0){

fprintf(stderr , "init attr failed: %s \n" , strerror(ret));

exit(1);

}

// 设置分离

ret = pthread_attr_setdetachstate(&attr , PTHREAD_CREATE_DETACHED);

if(ret != 0){

fprintf(stderr , "detach thread failed: %s \n" , strerror(ret));

exit(1);

}

// 查看

int detachstate;

pthread_attr_getdetachstate(&attr , &detachstate);

if(detachstate == PTHREAD_CREATE_DETACHED) {

printf("Successfully set status !!! \n");

}

// 创建线程

pthread_t tid;

ret = pthread_create(&tid , &attr , thread_handler , NULL);

if(ret != 0){

fprintf(stderr , "create thread failed: %s \n" , strerror(ret));

exit(1);

}

// 回收线程

ret = pthread_join(tid , NULL);

if(ret != 0){

fprintf(stderr , "resource thread failed : %s \n" , strerror(ret));

exit(1);

}

ret = pthread_attr_destroy(&attr);

if(ret != 0){

fprintf(stderr , "destroy attr failed : %s \n" , strerror(ret));

exit(1);

}

}

- 总结:

- 定义线程属性

- 初始化线程属性

- 设置线程属性为分离状态

- 借助修改之后的线程属性来创建分离态的线程

- 回收看是否分离成功

线程的使用注意事项

- 主线程退出其他线程不退出,主线程需要调用

pthread_exit方法 - 避免僵尸线程:

pthread_joinpthread_detachpthread_create指定分离属性,被join线程会受到线程在回收之前可能就释放完了自己的所有内存资源,所以不应当返回被回收线程栈中的值 malloc和mmap申请的内存可以被其他线程释放(共享堆区)- 需要避免在多线程模型中调用

fork,除非马上exec,子进程只有调用fork的进程存在,其他进程在子进程中都需要使用pthread_exit - 信号的复杂语义很难和多线程共存,应该避免在多线程中引入信号机制

线程同步

- 线程同步,指的就是一个线程发生功能调用的瞬间,在没有得到结果之前,该调用不用返回 同时其他线程为保证数据一致性,不能调用该功能

- 多个线程同时操作一个共享变量的时候就需要进行进程同步操作(比如取钱的时候,如果一个线程作了判断之后另外的线程也进来对于数据进行操作,那么就会导致两个线程都对于这一个数据进行了操作,但还是以为只有一个变量对于数据进行了操作导致出错)

- 数据混乱的原因:

- 资源共享(独享资源则不会)

- 调度随机(意味着数据访问会出现竞争)

- 线程之间缺乏必要的同步机制

利用互斥锁进行线程同步

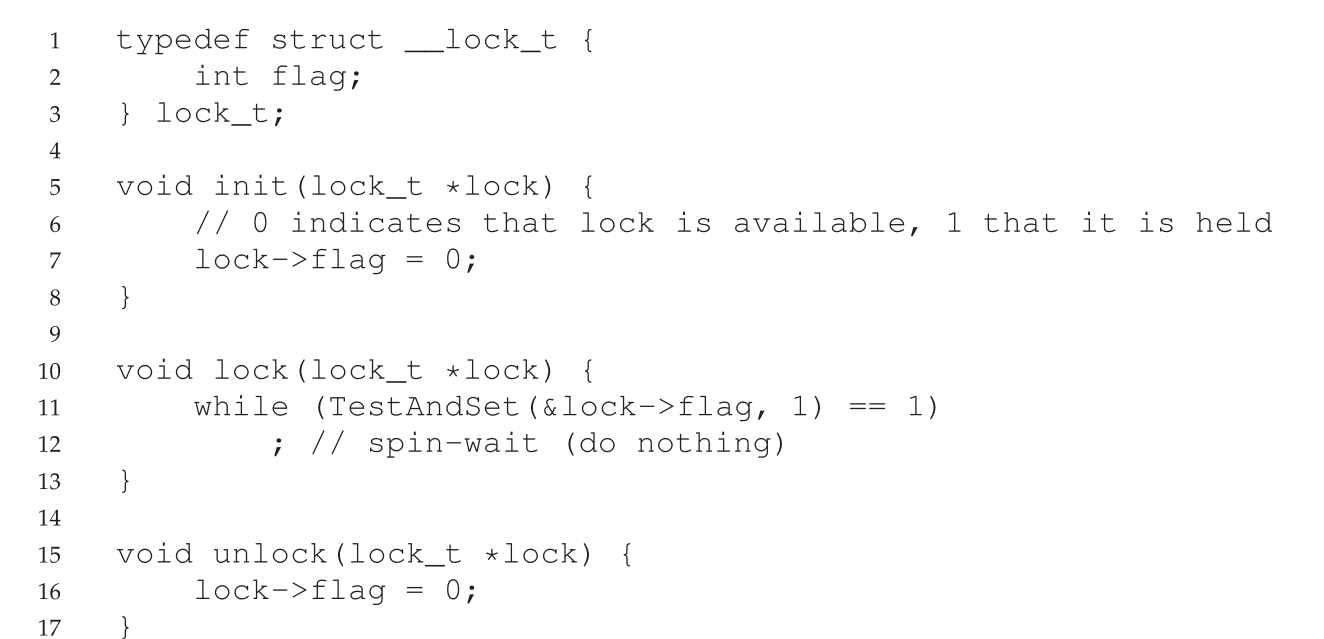

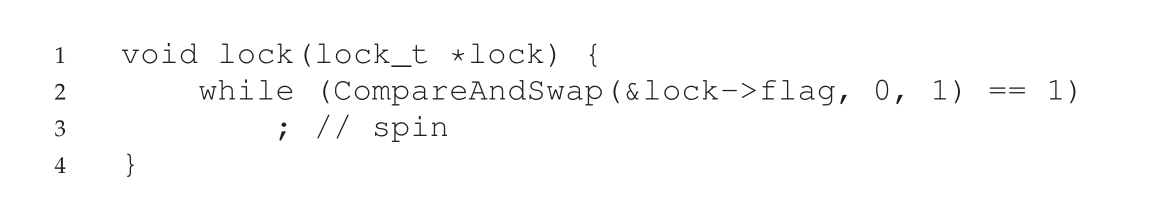

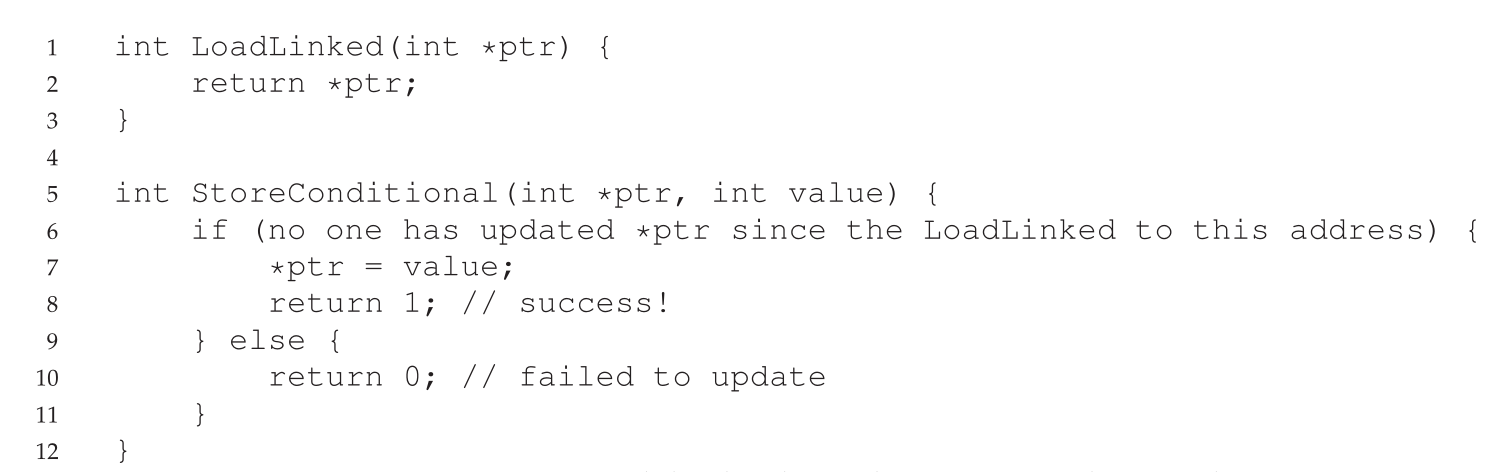

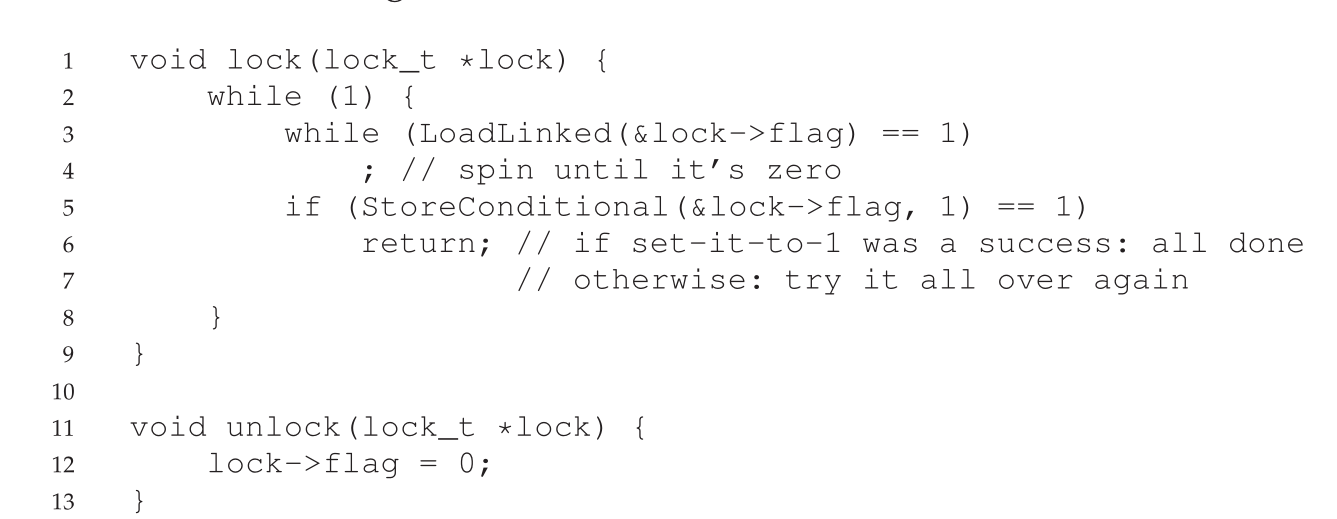

互斥量(mutex)

- 也就是互斥锁,作用就是利用互斥锁锁住全局变量,那么就可以保证公共资源每一次只会被一个线程进行操作,但是如果某一个线程直接访问全局变量那还是会导致数据不同布的问题,所以这些解决线程同步问题使用的锁都是建议锁而不是强制锁

- 锁的使用:

- 建议锁,用于锁住全局变量,锁住全局变量之后,就只有一个线程可以操作全局变量

操作函数

- 需要使用的函数如下:

pthread_mutex_init 函数

pthread_mutex_destory 函数

pthread_mutex_lock 函数

pthread_mutex_trylock 函数

pthread_mutex_unlock 函数

- 以上几个函数的返回值都是: 成功返回

0, 失败返回错误号 - 关注以下几个类型:

pthread_mutex_t 类型 本质是一个结构体,为了简化理解,应用的时候可以忽略实现细节,简单当成整数看待

pthread_mutex_t mutex; 变量 mutext只有两种取值: `0` 和 `1`

- 使用锁的步骤:

pthread_mutex_t lock创建锁pthread_mutex_init初始化pthread_mutex_lock加锁- 操作全局变量

pthread_mutex_unlock解锁pthread_mutex_destroy销毁锁

pthread_mutex_init函数

- 作用: 初始化锁

- 函数原型:

int pthread_mutex_init(pthread_mutex_t *restrict mutex,

const pthread_mutexattr_t *restrict attr);

- 参数:

mutex表示锁attr表示锁相关的配置

- 成功返回

0失败返回errorno restrict关键字用于限定指针变量,被该关键字限定的指针变量所指向的内存操作,必须由本指针完成

pthread_mutex_destory函数

- 作用: 销毁锁

- 函数原型:

int pthread_mutex_destroy(pthread_mutex_t *mutex);

- 参数:

- 表示需要释放的锁

pthread_mutex_lock函数

- 作用: 加锁

- 函数原型:

int pthread_mutex_lock(pthread_mutex_t *mutex);

- 参数:

- 表示所加上的锁

- 成功返回

0,失败返回errorno

pthread_mutex_unlock函数

- 作用: 解锁

- 函数原型:

int pthread_mutex_unlock(pthread_mutex_t *mutex);

- 参数: ...

- 返回值: ...

- 进行互斥锁操作的

demo如下: - 这里操作的全局变量就是

stdout

#include<stdio.h>

#include<stdlib.h>

#include<pthread.h>

#include<unistd.h>

#include<string.h>

// 定义锁

pthread_mutex_t mutex;

// 子线程需要执行的操作

void* thread_handler(void* arg)

{

while(1){

pthread_mutex_lock(&mutex);

printf("hello ");

sleep(rand() % 3);

printf("world \n");

pthread_mutex_unlock(&mutex);

sleep(rand() % 3);

}

return NULL;

}

int main()

{

// 随机时间种子

srand(time(NULL));

// 初始化锁

pthread_t tid;

int ret;

ret = pthread_mutex_init(&mutex , NULL);

if(ret != 0){

fprintf(stderr , "init mutex failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&tid , NULL , thread_handler , NULL);

if(ret != 0){

fprintf(stderr , "create thread failed: %s \n" , strerror(ret));

exit(1);

}

sleep(3);

while(1){

pthread_mutex_lock(&mutex);

printf("HELLO ");

sleep(rand() % 3);

printf("WORLD \n");

pthread_mutex_unlock(&mutex);

sleep(rand() % 3);

}

ret = pthread_mutex_destroy(&mutex);

if(ret != 0){

fprintf(stderr , "destory mutex failed: %s \n" , strerror(ret));

exit(1);

}

}

- 使用技巧: 注意

mutex的位置,不要再锁操作的代码中进行休眠,否则很容易导致某一个线程不断执行某一个业务逻辑,长时间占用CPU - 一定需要注意锁的粒度,越小越好(访问共享数据之前加锁,访问结束之后立刻解锁)

mutex类型可以看成int类型,初始化之后可以看作mutex = 1lock可以想象成mutex --同时unlock可以想象成mutex++,虽然本质就是结构体,但是这样利于学习- 对于

mutex的操作:- 加锁:

--操作,阻塞线程 - 解锁:

++操作,唤醒阻塞在锁上的线程 try锁: 尝试加锁,成功++,失败返回(注意此时不会阻塞,设置错误号为EBUSY)

- 加锁:

try锁使用pthread_mutex_trylock函数

死锁

- 不是一种锁,而是一种现象,是使用锁不恰当而导致的错误

- 会产生死锁的现象:

- 对于一个锁反复

lock(自己把自己锁住了) - 两个线程各自持有一把锁,都在请求另外一把锁

- 对于一个锁反复

- 两种现象的解释如下:

- 第一种情况的死锁:

#include<stdio.h>

#include<stdlib.h>

#include<pthread.h>

#include<unistd.h>

#include<string.h>

pthread_mutex_t mutex; // 模拟死锁

int var = 1;

void* thread_handler(void* arg)

{

while(var <= 100){

pthread_mutex_lock(&mutex);

pthread_mutex_lock(&mutex);

printf("[thread] tid = %ld , var = %d \n" , pthread_self() , var);

var ++;

pthread_mutex_unlock(&mutex);

pthread_mutex_unlock(&mutex);

}

return NULL;

}

int main()

{

pthread_t tid;

int ret;

ret = pthread_mutex_init(&mutex , NULL);

if(ret != 0){

fprintf(stderr , "init mutex error: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&tid , NULL , thread_handler , NULL);

if(ret != 0){

fprintf(stderr , "create mutex error: %s \n" , strerror(ret));

exit(1);

}

// 阻塞回收

ret = pthread_join(tid , NULL);

if(ret != 0){

fprintf(stderr , "join mutex error: %s \n" , strerror(ret));

exit(1);

}

// 销毁

ret = pthread_mutex_destroy(&mutex);

if(ret != 0){

fprintf(stderr , "destory mutex error: %s \n" , strerror(ret));

exit(1);

}

}

- 第二种情况的死锁:

#include<stdio.h>

#include<stdlib.h>

#include<string.h>

#include<unistd.h>

#include<pthread.h>

pthread_mutex_t mutex_a;

pthread_mutex_t mutex_b;

int var1 = 1;

int var2 = 1;

void* thread_handler1(void* arg)

{

while(var1 <= 100){

pthread_mutex_lock(&mutex_a);

pthread_mutex_lock(&mutex_b);

printf("[thread] tid = %ld , var1 = %d \n " , pthread_self() , var1);

var1 ++;

pthread_mutex_unlock(&mutex_b);

pthread_mutex_unlock(&mutex_a);

}

return NULL;

}

void* thread_handler2(void* arg)

{

while(var2 <= 100){

pthread_mutex_lock(&mutex_b);

pthread_mutex_lock(&mutex_a);

printf("[thread] tid = %ld , var1 = %d \n " , pthread_self() , var2);

var2 ++;

pthread_mutex_unlock(&mutex_a);

pthread_mutex_unlock(&mutex_b);

}

return NULL;

}

int main()

{

pthread_t tid[2];

int ret;

ret = pthread_mutex_init(&mutex_a , NULL);

if(ret != 0){

fprintf(stderr , "init mutex_a failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_mutex_init(&mutex_b , NULL);

if(ret != 0){

fprintf(stderr , "init mutex_b failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&tid[0] , NULL , thread_handler1 , NULL);

if(ret != 0){

fprintf(stderr , "create thread_a failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&tid[1] , NULL , thread_handler2 , NULL);

if(ret != 0){

fprintf(stderr , "create thread_b failed: %s \n" , strerror(ret));

exit(1);

}

// 回收

for(int i = 0 ; i < 2 ; i ++){

ret = pthread_join(tid[i] , NULL);

if(ret != 0){

fprintf(stderr , " join thread failed: %s \n" , strerror(ret));

exit(1);

}

}

// 销毁

ret = pthread_mutex_destroy(&mutex_a);

if(ret != 0){

fprintf(stderr , "destory thread_a failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_mutex_destroy(&mutex_b);

if(ret != 0){

fprintf(stderr , "destory thread_b failed: %s \n" , strerror(ret));

exit(1);

}

}

读写锁

- 与互斥锁类似,但是读写锁允许更高的并型性,他的特性为: 写独占,读共享

- 注意特点:

- 读共享,写独占

- 写锁优先级高

- 只有一把锁

- 使用读的方式给数据加锁--读锁,以写的方式给数据加锁--写锁

- 注意如果一个线程已经拿到锁了,就算是写锁的线程也会被阻塞,拿不到锁

- 这里思考以下为什么写锁的优先级别高,这是由于只有在写锁之后,读取到的数据才是真正的数据,避免了"读未提交的问题"

- 这里介绍几种情况,

Tn表示每一个线程n表示线程的顺序,n越小表示顺序越靠前:- 如果

T1为rT2为w那么T2就会获取锁 - 如果

T1为r并且已经获取到锁了,如果T2为w,那么T2还是会被阻塞,这是由于此时锁已经被获取了 - 如果

T1为r并且获取了锁 ,T2为rT3为w由于此时T3和T2都没有获取到锁,所以此时更具写锁优先级别高的元素应该是T3首先拿到锁,之后T2拿到进行数据的读取

- 如果

读写锁特性

- 读写锁是 "写模式加锁" 时,解锁之前,所有对该解锁加锁的线程都会被阻塞

- 读写锁是"读模式加锁" 时,如果线程使用读模式对其加锁成功,如果线程以写模式则会阻塞

- 读写锁时 "读模式加锁" 时,既有试图使用写模式加锁的线程,也有试图使用读模式加锁的线程,那么读写锁会阻塞随后的读模式锁请求,优先满足写模式锁,读锁写锁并行阻塞,但是写锁的优先级别高于读锁

- 读写锁也叫做共享-独占锁,当读写锁使用读模式锁住的时候,它是使用共享模式锁住的,当它使用写模式锁住的时候,它是使用独占模式锁住的,写独占,读共享

- 读写锁非常适合于对于数据结构的读的次数远大于写的次数

读写锁的常用函数

pthread_rwlock_initpthread_rwlock_destorypthread_rwlock_wrlockpthread_rwlock_rdockpthread_rwlock_trywrlockpthread_rwlock_tryrdlockpthread_rwlock_unlock- 以上的几个函数成功返回

0失败返回可以通过strerror()判断 - 锁的类型如下:

pthread_rwlock_t类型,用于定义一个读写锁变量pthread_rwlock_t rwlock

- 读写锁在读的线程多的时候效率会高于互斥锁

pthread_rwlock_init函数

- 作用: 初始化读写锁

- 函数原型:

int pthread_rwlock_init(pthread_rwlock_t *restrict rwlock,

const pthread_rwlockattr_t *restrict attr);

- 参数参考

pthread_lock_init

pthread_rwlock_destory函数

- 作用: 销毁读写锁

- 函数原型:

int pthread_rwlock_destroy(pthread_rwlock_t *rwlock);

- 注意其他函数基本可以参考互斥锁的相关的

API - 注意三句话即可:

- 读共享,写独占

- 写锁优先级高

- 全局只有一把读写锁

- 读写锁的

demo演示:

#include<stdio.h>

#include<pthread.h>

#include<stdlib.h>

#include<unistd.h>

#include<string.h>

// 读锁

int counter = 1;

pthread_rwlock_t rwlock; // 表示全局的读写锁

void* read_handler(void* arg)

{

int i = (int)arg;

while(1){

pthread_rwlock_rdlock(&rwlock);

printf("---------------read %d , tid = %lu , counter = %d \n" , i , pthread_self() , counter);

pthread_rwlock_unlock(&rwlock);

usleep(2000);

}

return NULL;

}

void* write_handler(void* arg)

{

int i = (int)arg;

int t;

while(1){

pthread_rwlock_wrlock(&rwlock);

usleep(1000);

t = counter;

printf("---------------write %d , tid = %lu , t = %d , counter = %d \n" , i , pthread_self() , t , ++counter);

pthread_rwlock_unlock(&rwlock);

usleep(5000);

}

return NULL;

}

int main()

{

// 初始化

pthread_rwlock_init(&rwlock , NULL);

pthread_t tid[8];

// 创建线程

int ret;

for(int i = 0 ; i < 3 ; i ++){

ret = pthread_create(&tid[i] , NULL , write_handler , (void*)i);

if(ret != 0){

fprintf(stderr , "create write thread failed: %s \n" , strerror(ret));

exit(1);

}

}

for(int j = 3 ; j < 8 ; j ++){

ret = pthread_create(&tid[j] , NULL , read_handler , (void*)j);

if(ret != 0){

fprintf(stderr , "create read lock failed: %s \n" , strerror(ret));

exit(1);

}

}

// 开始循环回收

for(int k = 0 ; k < 8 ; k ++){

pthread_join(tid[k] , NULL);

}

// 销毁锁

pthread_rwlock_destroy(&rwlock);

}

- 互斥锁:

pthread_mutex_t - 读写锁:

pthread_rwlock_t

条件变量

- 条件变量本身不是锁,但是它也可以造成线程阻塞,通常情况下与互斥锁配合使用,给多线程提供一个会合的场所

主要的应用函数

pthread_cond_initpthread_cond_destroypthread_cond_wait(相当于条件满足)pthread_cond_timewait(等待条件满足相当于try锁)pthread_cond_signal(表示条件满足进行通知)pthread_cond_broadcast(表示通知的时候使用广播模式)- 以上六个函数的返回值都是成功返回

0, 失败直接返回错误号 - 常用类型:

pthread_cond_t类型,用于定义条件变量pthread_cond_t cond

pthread_cond_init函数

- 作用: 初始化一个条件变量

- 注意条件判断

- 函数原型:

int pthread_cond_init(pthread_cond_t *restrict cond,

const pthread_condattr_t *restrict attr);

pthread_cond_t cond = PTHREAD_COND_INITIALIZER;

- 参数和返回值不用多说,此时可以说一下后面的静态初始化方式,其实就是利用宏定义来初始化这一个锁,基本上和

pthread_mutex_init和pthread_rwlock_init类似

pthread_cond_wait函数

- 作用:

- 阻塞等待条件变量

cond满足 - 释放已经掌握的互斥锁(解锁互斥量),相当于

pthread_mutex_unlock(注意1和2是一个原子操作) - 当被唤醒,

pthread_cond_wait函数返回的时候,解除阻塞并且重新申请互斥锁(pthread_mutex_lock)

- 阻塞等待条件变量

- 函数原型:

int pthread_cond_wait(pthread_cond_t *restrict cond,

pthread_mutex_t *restrict mutex);

pthread_cond_wait工作原理:

条件变量的生产者消费者模型

- 生产者消费者模型图如下:

- 公共操作:

- 首先定义锁

pthread_mutex_t lock - 初始化锁

pthread_mutex_init(&lock , NULL)

- 首先定义锁

- 消费者:

- 加锁(尝试获取数据):

pthread_mutex_lock(&lock) - 条件是否满足,不满足阻塞等待:

pthread_cond_wait(&cond , &lock) - 访问共享数据

- 释放锁

pthread_mutex_unlock(&lock),并且循环上述操作

- 加锁(尝试获取数据):

- 生产者:

- 生产数据

- 尝试获取锁(加锁):

pthread_mutex_lock(&lock) - 将数据存放到公共区域

- 解锁

pthread_mutex_unlock(&lock) - 唤醒消费者,满足条件:

pthread_cond_signal(&cond)或者pthread_cond_broadcast(cond) - 循环生产后续数据

- 消费者生产者模型代码实现:

#include<stdio.h>

#include<stdlib.h>

#include<string.h>

#include<unistd.h>

#include<pthread.h>

typedef struct msg{

int num;

struct msg* next;

}Msg; // 共享数据相当于链表

pthread_mutex_t mutex; // 互斥锁

pthread_cond_t cond; // 条件变量

Msg* pub_msg; // 表示公共的数据

int i; // 表示消息的编号

// 消费者

void* consumer_handler(void* arg)

{

while(1){

// 1. 首先尝试获取数据,加锁

pthread_mutex_lock(&mutex);

// 2. 判断条件变量是否满足

while(pub_msg -> next == NULL){ // 注意条件判断,如果公共数据区存在数据的,那么就可以直接取出数据

pthread_cond_wait(&cond , &mutex);

}

// 3. 访问共享数据,此时已经加锁了

// 利用头删法消费数据

Msg* temp = pub_msg -> next;

pub_msg -> next = temp -> next;

printf("消费者获取: Message-%d \n" , temp -> num);

free(temp);

// 4. 释放锁

pthread_mutex_unlock(&mutex);

sleep(rand() % 3);

}

return NULL;

}

// 生产者

void* producer_handler(void* arg)

{

while(1){

// 1. 首先生产数据

Msg* node = (Msg*) malloc (sizeof(Msg));

sleep(1);

node -> num = i;

i ++;

// 2. 尝试加锁

pthread_mutex_lock(&mutex);

// 3. 把数据放入到公共区域

node -> next = pub_msg -> next;

pub_msg -> next = node;

printf("生产者生产: Message-%d \n" , node -> num);

// 4. 解锁

pthread_mutex_unlock(&mutex);

// 5. 唤醒消费者

pthread_cond_signal(&cond);

sleep(rand() % 3);

}

return NULL;

}

int main()

{

// 初始化

srand(time(NULL));

i = 1;

pthread_mutex_init(&mutex , NULL);

pthread_cond_init(&cond , NULL);

pub_msg = (Msg*) malloc (sizeof(Msg));

// 创建线程

int ret;

pthread_t consumer_tid , producer_tid;

ret = pthread_create(&consumer_tid , NULL , consumer_handler , NULL);

if(ret != 0){

fprintf(stderr , "create consumer failed: %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&producer_tid , NULL , producer_handler , NULL);

if(ret != 0){

fprintf(stderr , "create producer failed: %s \n" , strerror(ret));

exit(1);

}

// 回收

pthread_join(consumer_tid , NULL);

pthread_join(producer_tid , NULL);

pthread_cond_destroy(&cond);

pthread_mutex_destroy(&mutex);

}

多个消费者使用while做

- 分析一下多个消费者消费时候的流程: 当某一个线程被唤醒的时候,由与使用的都是同样一个

cond所以都会被唤醒,所以如果被唤醒之后即可结束(使用if)判断条件的情况下,这一个线程就会立刻阻塞到lock的位置导致缺少对于公共数据是否为空减少判断导致出错 - 改进代码如下:

#include<stdio.h>

#include<stdlib.h>

#include<string.h>

#include<unistd.h>

#include<pthread.h>

typedef struct msg{

int num;

struct msg* next;

}Msg; // 共享数据相当于链表

pthread_mutex_t mutex; // 互斥锁

pthread_cond_t cond; // 条件变量

Msg* pub_msg; // 表示公共的数据

int i; // 表示消息的编号

// 消费者

void* consumer_handler(void* arg)

{

int v = (int)arg;

while(1){

// 1. 首先尝试获取数据,加锁

pthread_mutex_lock(&mutex);

// 2. 判断条件变量是否满足

while(pub_msg -> next == NULL){ // 注意条件判断,如果公共数据区存在数据的,那么就可以直接取出数据

pthread_cond_wait(&cond , &mutex);

}

// 3. 访问共享数据,此时已经加锁了

// 利用头删法消费数据

Msg* temp = pub_msg -> next;

pub_msg -> next = temp -> next;

printf("消费者:%d 获取: Message-%d \n" , v + 1, temp -> num);

free(temp);

// 4. 释放锁

pthread_mutex_unlock(&mutex);

sleep(2);

}

return NULL;

}

// 生产者

void* producer_handler(void* arg)

{

while(1){

// 1. 首先生产数据

Msg* node = (Msg*) malloc (sizeof(Msg));

sleep(1);

node -> num = i;

i ++;

// 2. 尝试加锁

pthread_mutex_lock(&mutex);

// 3. 把数据放入到公共区域

node -> next = pub_msg -> next;

pub_msg -> next = node;

printf("生产者生产: Message-%d \n" , node -> num);

// 4. 解锁

pthread_mutex_unlock(&mutex);

// 5. 唤醒消费者

pthread_cond_signal(&cond);

sleep(0.5);

}

return NULL;

}

int main()

{

// 初始化

srand(time(NULL));

i = 1;

pthread_mutex_init(&mutex , NULL);

pthread_cond_init(&cond , NULL);

pub_msg = (Msg*) malloc (sizeof(Msg));

// 创建线程

int ret;

pthread_t producer_tid;

pthread_t consumer_tid[2];

for(int j = 0 ; j < 2 ; j ++){

ret = pthread_create(&consumer_tid[j] , NULL , consumer_handler , (void*)j);

if(ret != 0){

fprintf(stderr , "create consumer failed: %s \n" , strerror(ret));

exit(1);

}

}

ret = pthread_create(&producer_tid , NULL , producer_handler , NULL);

if(ret != 0){

fprintf(stderr , "create producer failed: %s \n" , strerror(ret));

exit(1);

}

// 回收

for(int j = 0 ; j < 2 ; j ++){

pthread_join(consumer_tid[j] , NULL);

}

pthread_join(producer_tid , NULL);

pthread_cond_destroy(&cond);

pthread_mutex_destroy(&mutex);

}

条件变量 signal注意事项

pthread_cond_signal(): 唤醒阻塞在条件变量上的(至少)一个线程pthread_cond_broadcast(): 唤醒阻塞在条件变量上的所有线程

信号量

- 相当于初始化值为

N的互斥量,可以当成锁看待(这样允许有N个线程同时操作共享变量,提高了执行效率)(N表示可以同时执行对于共享变量操作的线程个数)

主要应用函数

sem_initsem_destroysem_waitsem_trywait(相当于pthread_mutex_trylock)sem_timedwaitsem_post- 以上函数的返回值都是成功返回

0,失败返回-1,同时设置error(注意没有pthread前缀) - 使用的信号量类型:

sem_t类型: 本质仍然是结构体,但是应用期间可以看成简单函数,忽略实现细节(类似于文件描述符)sem_t sem规定信号量sem不可以< 0- 头文件:

<semaphore.h>

信号量操作函数

sem_wait:- 信号量大于

0,则信号量-- - 信号量等于

0,则造成信号阻塞 - 对应于

pthread_mutex_lock

- 信号量大于

sem_post:- 将信号量

++,同时唤醒阻塞在信号量上面的线程(类比pthread_mutex_unlock)

- 将信号量

- 但是,由于

sem_t的实现对于用户隐藏,所以所谓的操作++或者--都是只可以通过函数实现,不可以直接通过++,--符号 - 信号量的初始值决定了占用信号量的线程个数

- 信号量: 可以应用于线程或者进程

sem_init函数

- 作用: 初始化信号量

- 函数原型:

int sem_init(sem_t *sem, int pshared, unsigned int value);

- 参数:

sem信号量pshared0表示线程之间同步,1表示进程之间同步value就是表示 信号量的N

其他函数

sem_timedwait: 指定阻塞时间(尝试时间)- 函数原型如下:

int sem_timedwait(sem_t *restrict sem,

const struct timespec *restrict abs_timeout);

- 注意第二个参数:

abs_timeout就是指的绝对时间相当于1970.01.01

利用信号量实现生产者消费者模型

- 利用信号量实现生产者消费者模型:

- 注意实现方式中可以把

sem_wait当成对于信号量的--操作,sem_post看成++操作 - 代码实现如下:

#include<stdio.h>

#include<stdlib.h>

#include<unistd.h>

#include<pthread.h>

#include<string.h>

#include<semaphore.h>

#define NUM 5 // 表示队列的最大长度

int queue[NUM]; // 表示队列

sem_t star_num; // 表示 物品的数量

sem_t blank_num; // 表示空格的数量

// 消费者

void* consumer_handler(void* arg)

{

int i = 0; // 表示开始下标

while(1){

// 1. 首先利用 star_num 锁住

sem_wait(&star_num);

// 2. 消费元素

int target = queue[i];

printf("-----consumer: %d \n" , target);

queue[i] = 0;

// 3. 唤醒生产者

sem_post(&blank_num);

i = (i + 1) % NUM;

sleep(rand() % 3);

}

return NULL;

}

// 生产者

void* producer_handler(void* arg)

{

int i = 0;

while(1){

// 1. 首先利用blank_num锁住

sem_wait(&blank_num);

queue[i] = rand() % 1000 + 1;

printf("-----producer: %d \n" , queue[i]);

// 2. 表示唤醒消费者

sem_post(&star_num);

i = (i + 1) % NUM;

sleep(rand() % 3);

}

return NULL;

}

int main()

{

// 初始化信号量

srand(time(NULL));

for(int i = 0 ; i < NUM ; i ++){

queue[i] = 0;

}

sem_init(&star_num , 0 , 0);

sem_init(&blank_num , 0 , NUM);

// 创建线程

pthread_t consumer_tid , producer_tid;

int ret;

ret = pthread_create(&consumer_tid , NULL , consumer_handler , NULL);

if(ret != 0){

fprintf(stderr , "create consumer failed : %s \n" , strerror(ret));

exit(1);

}

ret = pthread_create(&producer_tid , NULL , producer_handler , NULL);

if(ret != 0){

fprintf(stderr , "create producer failed : %s \n" , strerror(ret));

exit(1);

}

// 回收

pthread_join(consumer_tid , NULL);

pthread_join(producer_tid , NULL);

// 销毁

sem_destroy(&star_num);

sem_destroy(&blank_num);

}

gcc

gcc 编译四步骤

gcc编译四步骤:- 预处理(展开宏定义,头文件,替换条件编译,删除注释,空行空白)

- 编译(检查语法规范,得到汇编代码)

- 汇编(将汇编指令翻译成机器指令)

- 链接(数据段合并,地址回填)

- 注意

-o的作用就是起名字,而不是链接 - 其中编译阶段消耗时间和系统资源最多

g++使用方式一样:

$ g++ -E hello1.cpp -o hello1.i

$ g++ -S hello1.i -o hello1.s

$ g++ -c hello1.s -o hello1.o

$ g++ hello1.o -o hello1

gcc常用的参数

-I 目录用于指定头文件,头文件和源代码不再同一个目录下就需要指定头文件- 制定了头文件的位置,或者指定了位置

# 指定头文件所在的目录

$ gcc hello.c -I ../inc -o hello

-c预处理编译和汇编,相当于进行了后面的步骤,前面的步骤执行了,所以最后使用的编译命令:

# 这里没有参数,已经完成了链接和之前的操作

$ gcc hello.c -o hello

-g编译时添加调试语句(可以调试)-On n=0~3编译优化,n的值越大优化越多(嵌入式编程中需要使用放置优化)-Wall显示所有的警告信息

$ gcc hello.c -o hello -Wall

-D表示向当前程序中注册一个宏,一般可以配合#ifdef使用,注意#ifndef表示没有定义

gcc hello.c -o hello -D HELLO

#include "../inc/hello.h"

#ifdef HELLO

#define HI 20

#endif

void say_hello()

{

printf("hello world");

}

int main()

{

say_hello();

printf("%d\n",HI);

return 0;

}

静态库和共享库(动态库)

- 静态库: 任何一个程序需要使用必须编译这一个静态库,静态库被编译到程序中,相当于库就相当于自己的函数

- 动态库: 只需要链接就可以了,不用编译到程序中

- 静态库优点:

- 效率比较高

- 动态库优点:

- 占用空间比较小

- 静态库: 对于空间要求比较低,时间要求比较高,比如操作系统的启动文件中

- 动态库: 对于时间要求比较低,对于空间要求比较高

制作静态库

- 自己写程序一般不写静态库

- 制作语法:

- 首先生成

.o文件

- 首先生成

# 获取 .o

$ gcc -c hello.c -o hello.o

$ ar rcs libmylib.a file1.o

linux中静态库的后缀:.a,windows中后缀:.lib

$ gcc -c add.c -o add.o

$ gcc -c sub.c -o sub.o

$ ar rsc mymathlib.a add.o sub.o

- 使用静态库

- 编译阶段出错会有行号

ld表示连接器,所以如果有ld就是链接出错

# 直接把静态库编译进去就可以了

$ gcc test.c mymathlib.a -o test

- 加上

-Wall会有如下警告信息: - 意思就是隐式声明,原因就是当函数没有定义并且没有声明的时候,编译器就会隐式声明

- 但是隐式声明必须需要推导出返回值和参数类型

test.c:6:28: warning: implicit declaration of function ‘add’ [-Wimplicit-function-declaration]

6 | printf("a + b = %d\n", add(a , b));

- 头文件守卫(作用就是放置同一个头文件重复包含)

#ifndef _MYMATH_H_

#define _MYMATH_H_

int add(int a , int b);

int sub(int a , int b);

#endif

- 总结一下问题:

- 如果没有在头文件中定义需要使用的函数,那么就会导致使用的时候如果使用

-Wall参数就会报错implicit declaration of ... - 所以在制作静态库的时候需要提供一个头文件用于声明好需要使用的函数

- 编译时利用

-I参数连接好头文件就可以了,当然需要在代码中include头文件

- 如果没有在头文件中定义需要使用的函数,那么就会导致使用的时候如果使用

- 常用的

C项目结构如下:inc: 存放头文件lib: 存放库文件src: 存放源代码

$ gcc test.c ../lib/mymathlib.a -o ../output/test -I ../inc

制作动态库

- 只有当调用到动态库中的函数的时候,才会加载这一个文件

- 地址回填: 汇编阶段之后,生成了

Xxx.o二进制代码,但是这一个代码中main函数的地址还没有确定(运行时才会确定),但是main函数中自己定义的函数的地址和main发生了绑定关系,比如main函数中定义了func那么汇编阶段之后,func的地址虽然没有确定,但是与main函数地址之间的关系确定了,当运行阶段main地址分配了,就叫做地址回填,此时func的地址才可以确定 - 只有在运行的时候,动态库的函数才可以被

main调用,所以动态库的函数晚绑定,所以需要生成地址固定的代码才可以制作动态库 - 制作过程:

- 利用

-c制作.o文件,制作位置无关的代码,这是由于调用的过程中需要让地址固定(-fPIC参数可以做到) - 使用

gcc -shared 制作动态库

- 利用

# 生成代码与位置无关的 .o 文件

gcc -c add.c -o add.o -fPIC

# 利用生成的代码制作动态库

gcc -shared -o lib库名.so add.o sub.o div.o

# 使用动态库.编译可执行程序的时候,指定使用的动态库 -l 指定库名 -L: 指定库的路径

gcc test.c -o test -l mymath -L ./lib

-l 指定库名-L 指定库的路径

# 编译指令

$ gcc dtest.c -o ../output/dtest -l mymath -L ../lib -I ../inc

- 注意上面会报错,找不到文件:

- 原因:

- 链接器: 工作处于链接阶段,工作时需要

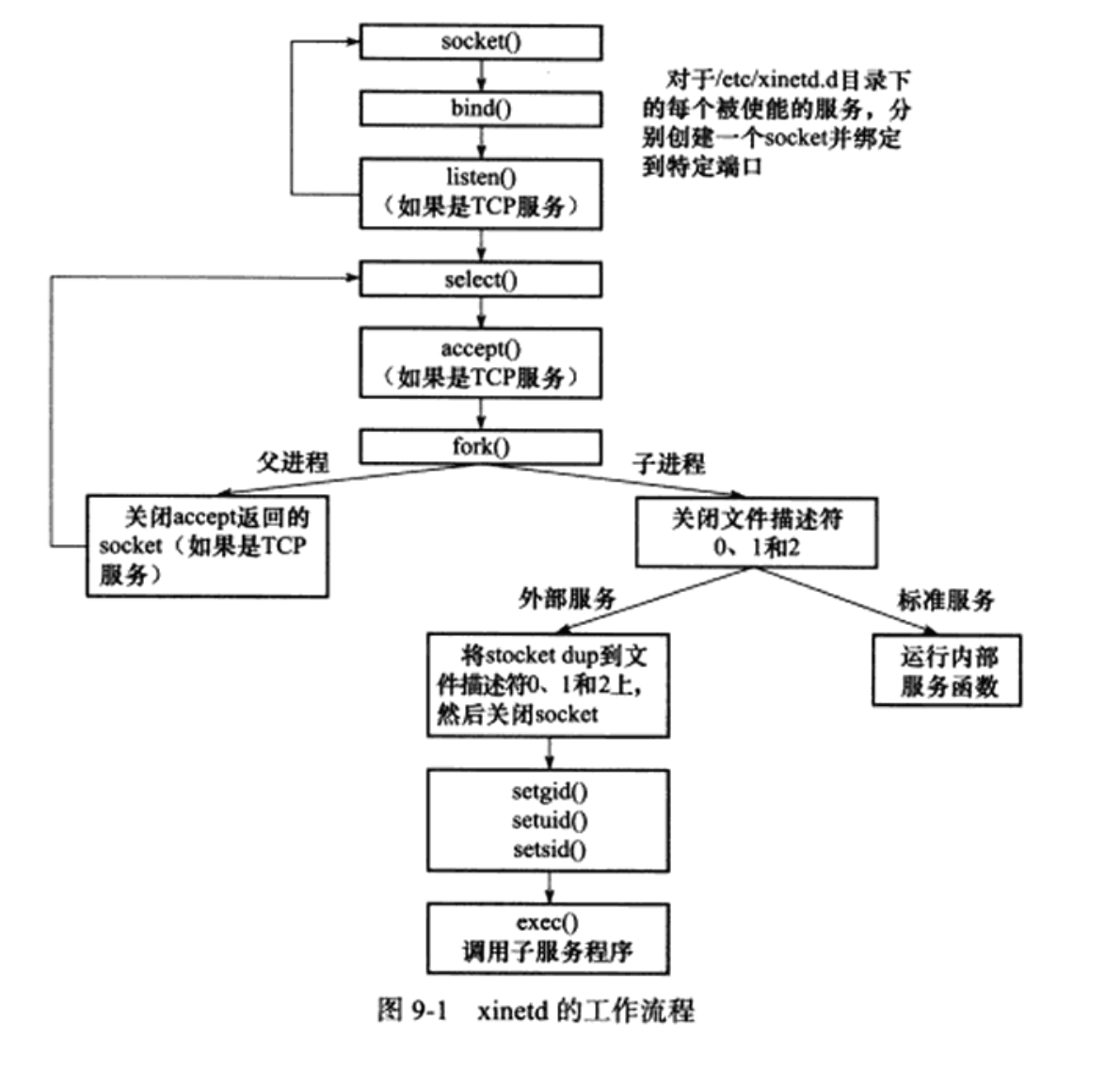

-l和-L参数(完成数据段合并和地址回填) - 动态链接器: 工作处于程序运行阶段,工作时需要提供动态库所在的目录位置,会到特定的位置去找动态库(

LD_LIBRARY_PATH=./lib)

- 链接器: 工作处于链接阶段,工作时需要

- 注意动态库的名称一定需要需要使用 lib库名.so 的名称,链接时需要使用 库名(去掉 lib 和 so)

- 但是直接改变

LD_LIBRARY_PATH的方法不可取,最好把动态库安装到/usr/lib目录下便于寻找 - 为什么我的可以运行?

- 可以使用

ldd查看加载动态库的路径 - 解决方式:

- 改变

LD_LIBRARY_PATH的值 - 把自己的动态库放在

/lib下,这是由于gcc编译器会自动在/lib下寻找动态库(利用ldd可以查看) - 配置文件法:

- 编辑配置文件

/etc/ld.so.conf,include自己的动态库路径即可 - 之后让这一个配置文件生效

ldconfig /etc/ld.so.conf即可

- 编辑配置文件

- 改变

- 注意动态库和静态库都需要指定头文件

- 数据段合并的原理(之后学习了操作系统的内存管理在看):

- 其实底层就是链接时期,完成

.bss和.data的合并和.rodata和.text的合并

- 其实底层就是链接时期,完成

- 总结:

- 静态库制作步骤:

# 首先生成 .o 文件

$ gcc -c add.c -o add.o

$ gcc -c sub.c -o sub.o

# 利用 .o 文件生成静态库

$ ar rsc 静态库名称.a add.o sub.o

# 使用静态库

$ gcc test.c 静态库名.a -I 头文件路径 -o a.out

- 动态库制作步骤:

# 首先生成 .o 文件(地址和代码位置无关)

$ gcc -c add.c -o add.o -fPIC

$ gcc -c sub.c -o sub.o -fPIC

# 利用 .o 文件生成静态库

$ gcc -shared -o lib动态库名.so add.o sub.o

# 使用静态库

$ gcc test.c -o a.out -l 动态库名 -I 头文件路径 -L 动态库路径

- 解决动态链接器找不到动态库的问题:

- 改变(

LD_LIBRART_PATH) - 把

.so放在/lib下 - 配置

/etc/ld.so.conf,并且利用ldconfig时的这一个文件生效

- 改变(

gdb

- 调试作用

- 注意需要加上

-g用于生成调试信息,从而可以使用gdb进行检测 - 使用方式:

gdb 可执行程序名称进入调试状态list或者l显示源码list n或者l n表示从第n行开始显示源码b n表示在第n行设置断点run或者r表示执行程序,一般用于执行到断点的位置n表示next越过这一行直接进入下一行(在调试的时候使用)s表示进入这一行(step)p value可以用于查看变量的值,这就是表示查看value的值continue表示继续执行下面的函数,相当于放行quit退出

gdb进阶命令

- 如果出现了段错误,那么直接使用

run命令就可以,直接使用run命令,停止的位置就是段错误的位置 start命令表示从当前行开始执行(相当于当前行打了一个断点),之后可以使用s或者n进行下一步finish表示退出当前函数,回到进入函数的位置(结束当前函数调用,返回进入点)- 注意设置断点之后一定需要 `run

set args表示设置程序运行的参数,set args "aa" "bb" "cc" "dd"info b表示设置断点信息b 20 if i = 5表示只有i = 5的时候才可以设置断点,相当于循环中间才会让断点生效ptype 变量表示查看变量的类型- 栈帧: 表示随着函数的调用而在

stack开辟的一片内存空间,用于存放函数调用时产生的局部变量和临时值,当函数执行完毕的时候,栈帧就会消失,并且栈帧中存储着函数执行过程中的局部变量 backtrace(bt)查看函数的调用的栈帧和层级关系frame(f)切换函数的栈帧,作用就是可以在执行一个函数的同时切换到另外一个函数的栈帧的位置查看另外一个函数中的局部变量,但是前提就是这些函数没有执行完毕(注意使用run执行到断点的位置)display设置跟踪变量,对于一个变量使用了display之后,这一个变量就会被纳入到跟踪列表,之后使用display就可以跟踪变量undisplay 号码就可以取消对应号码的跟踪,下一次使用display就不会展示这一个变量了delete删除断点info locals查看局部变量- 常见错误:

- 没有符号表读取: 没有

-g选项

- 没有符号表读取: 没有

Makefile

- 相当于脚本,相当于一组命令的集合

Makefile中的注意点:- 一个规则

- 两个函数

- 三个自动变量

规则

- 一个规则:

- 目标: 依赖条件 # 表示格式

(一个

tab缩进)命令 - 命名方式(

makefile或者Makefile)

- 目标: 依赖条件 # 表示格式

(一个

- 一个最简单的

makefile如下:

hello:hello.c # 目标:依赖

gcc hello.c -o hello # 生成目标的命令

- 另外一个例子:

# hello:hello.c

# gcc hello.c -o hello

hello:hello.o

gcc hello.o -o hello

hello.o:hello.c

gcc -c hello.c -o hello.o

- 规则: 如果想要生成目标(比如

hello.o),检查规则中的依赖条件是否存在,如果不存在,就可以寻找是否存在规则用来生成该依赖文件(可以使用hello.c生成规则) - 考虑如下的

makefile文件:

test: add.c sub.c div1.c mul.c test.c

gcc test.c add.c sub.c div1.c mul.c -o test

- 如果这样写的话,如果其中的某一个文件发生了改变,如果还是利用这一个指令,那么没有改变的文件救护重复编译,造成时间的浪费

- 所以可以提前生成

.o文件 - 改写之后的

makefile如下:

# test: add.c sub.c div1.c mul.c test.c

# gcc test.c add.c sub.c div1.c mul.c -o test

test:add.o sub.o div1.o mul.o test.o

gcc test.o add.o sub.o div1.o mul.o -o test

add.o:add.c

gcc -c add.c -o add.o

sub.o:sub.c

gcc -c sub.c -o sub.o

div1.o:div1.c

gcc -c div1.c -o div1.o

mul.o:mul.c

gcc -c mul.c -o mul.o

test.o:test.c

gcc -c test.c -o test.o

- 此时指挥编译被修改过的文件

- 规则2: 检测规则中的目标是否需要更新,必须首先检测他的所有依赖,依赖中有任何一个被更新,则目标都会被更新

- 总结规则:

- 目标的时间必须晚于依赖条件的时间,否则就会更新目录

- 依赖条件如果不存在,找寻新的规则去产生依赖

- 注意

makefile会默认把第一个遇到的目标作为终极目标,如果这一个目标的依赖关系已经满足,那么就不会继续执行下面的目标了,所以生成可执行文件需要写在前面 - 但是可以指定

ALL 目标文件就可以解决这一个文件

# test: add.c sub.c div1.c mul.c test.c

# gcc test.c add.c sub.c div1.c mul.c -o test

# 表示指定终极目标

ALL: test

add.o:add.c

gcc -c add.c -o add.o

sub.o:sub.c

gcc -c sub.c -o sub.o

div1.o:div1.c

gcc -c div1.c -o div1.o

mul.o:mul.c

gcc -c mul.c -o mul.o

test.o:test.c

gcc -c test.c -o test.o

test:add.o sub.o div1.o mul.o test.o

gcc test.o add.o sub.o div1.o mul.o -o test

函数

wildcard函数

src = $(wildcard *.c)用于找到当前目录下的所有的.c文件,赋值给src

patsubst

obj = $(patsubst %.c , %.o , $(src))把src变量里面所有后缀为.c的文件替换成.o- 作用: 将包含参数

1的部分,替换成参数2 - 同时可以使用

clean删除所有的.o文件和原来生成的可执行文件 - 首先使用

make clean -n查看清除语句 - 之后利用

make clean删除语句

src = $(wildcard *.c) # src = add.c sub.c div1.c mul.c test.c

obj = $(patsubst %.c , %.o , $(src)) # obj = add.o sub.o div1.o mul.o test.o

test:$(obj)

gcc $(obj) -o test

add.o:add.c

gcc -c add.c -o add.o

sub.o:sub.c

gcc -c sub.c -o sub.o

div1.o:div1.c

gcc -c div1.c -o div1.o

mul.o:mul.c

gcc -c mul.c -o mul.o

test.o:test.c

gcc -c test.c -o test.o

clean:

-rm -rf $(obj) test

- 注意

clean没有依赖,并且-rm中-的作用就是删除不存在的文件的时候不会报错

自动变量

$@表示规则中的目标,在规则的命令中表示目标,只可以出现在命令的位置$<表示规则中的第一个条件,在规则的命令中表示第一个依赖条件如果引用到模式规则中,他可以把依赖条件列表中的依赖一次取出,套用于模式规则(相当于 一次循环)$^表示规则中的所有条件,表示所有依赖条件

src = $(wildcard *.c) # src = add.c sub.c div1.c mul.c test.c

obj = $(patsubst %.c , %.o , $(src)) # obj = add.o sub.o div1.o mul.o test.o

test:$(obj)

gcc $^ -o $@

add.o:add.c

gcc -c $< -o $@

sub.o:sub.c

gcc -c $< -o $@

div1.o:div1.c

gcc -c $< -o $@

mul.o:mul.c

gcc -c $< -o $@

test.o:test.c

gcc -c $< -o $@

clean:

-rm -rf $(obj) test

- 好处就是当程序中多了一个模块的时候,不用修改

makefile就可以了利用make编译得到可执行程序 - 模式规则: 可以使用模式匹配模拟规则:

%.o:%.c命令也是通用的 - 模式规则如下:

src = $(wildcard *.c) # src = add.c sub.c div1.c mul.c test.c

obj = $(patsubst %.c , %.o , $(src)) # obj = add.o sub.o div1.o mul.o test.o

test:$(obj)

gcc $^ -o $@

%.o:%.c

gcc -c $< -o $@

clean:

-rm -rf $(obj) test

- 静态模式规则:

$(obj):%.o:%.c gcc -c $< -o $@

- 表示对于某一个条件套用某一个模式规则,当模式规则不只有一个的时候,那么就会导致不知道需要找到那一个依赖才可以满足依赖关系

src = $(wildcard *.c) # src = add.c sub.c div1.c mul.c test.c

obj = $(patsubst %.c , %.o , $(src)) # obj = add.o sub.o div1.o mul.o test.o

test:$(obj)

gcc $^ -o $@

$(obj):%.o:%.c

gcc -c $< -o $@

%.s:%.c

gcc -S $< -o $@

clean:

-rm -rf $(obj) test

- 如果定义一个

clean文件,使用make clean的时候,就会被错误解析成需要制作一个clean文件 - 所以此时需要使用伪目标(不论是否符合条件都需要生成目标)

- 就是无论符合条件都会执行(

PHONY)

src = $(wildcard *.c) # src = add.c sub.c div1.c mul.c test.c

obj = $(patsubst %.c , %.o , $(src)) # obj = add.o sub.o div1.o mul.o test.o

test:$(obj)

gcc $^ -o $@

$(obj):%.o:%.c

gcc -c $< -o $@

%.s:%.c

gcc -S $< -o $@

clean:

-rm -rf $(obj) test

.PHONY: clean ALL

- 同时也可以链接静态库和动态库(

-l-L-Wall) - 注意

makefile中*的作用就是通配符号,但是%表示占位符号,用于指定特殊为位置的字符,一定需要注意二者的区别,在进行模式匹配的时候,一定需要注意使用%指定目标和依赖的位置关系

src = $(wildcard ./src/*.c) # src = *.c

obj = $(patsubst ./src/%.c , ./obj/%.o , $(src)) # obj = ./obj/add.o ./obj/sub.o ./sub/mul.c

ALL: test

include_path = ./inc

my_args = -Wall -g

test:$(obj)

gcc $^ -o $@ $(my_args) -I $(include_path)

$(obj):./obj/%.o:./src/%.c # 此时 注意 % 匹配的就是 add sub mul 就可以了,注意一定需要找到依赖的位置

gcc -c $< -o $@ $(my_args) -I $(include_path)

clean:

-rm -rf $(obj) test

.PHONY: clean ALL

# 注意头文件链接发生在预处理阶段,这里只需要链接所以不用 -I ./inc

- 注意预处理阶段就完成了头文件的展开,所以这里的链接阶段应该不需要头文件,但是为什么没有头文件也会报错 ????

- 或者可以使用如下参数:

-n模拟执行make命令-f指定文件执行make命令xxx.mk

- 注意

$(obj):%.o:%.c的含义,表示如果依赖是$(obj)需要依靠这一条规则生成,如果没有如上依赖,那么就不会作任何事情 - 以下

makefile用于生成该目录下所有可执行程序

src=$(wildcard *.c)

out=$(patsubst %.c,%,$(src))

ALL: $(out)

%:%.c

gcc $< -o $@

clean:

-rm -rf $(out)

.PYHONY: clean ALL

- 注意静态模式匹配的含义: 确定了需要匹配的字符串,对于这一个字符串,利用

%进行模式匹配,同时依赖中的%依赖于target中的% - 如果在同一个目录下

%表示匹配同一个名称 - 还可以指定文件:

src=$(wildcard ./src/*.c)

out=$(patsubst ./src/%.c,./out/%,$(src))

ALL: $(out)

./out/%:./src/%.c

gcc $< -o $@

clean:

-rm -rf $(out)

.PYHONY: clean ALL

- 总结一下: 如果使用模式匹配的方式,首先会利用依赖的匹配字符串在依赖的目录位置找到名称,确定

%的值,从而确定目标的名称,确定目标的名称之后,就可以通过命令生成对应的目标了 - 静态模式匹配使用的情况就是可以使用多种方式生成依赖,指定生成的方式,所以一般情况下不要使用

CMake

介绍

- 一种项目构建工具,如果使用编写

makefile的方式构建项目,由于不同的平台使用的构建构建工具不同(VS中的nmake和QtCreator中qmake)所以makefile依赖于当前的平台,利用cmake构建项目就可以自动生成makefile达到了跨平台的效果,同时由于makefile编写起来工作量太大,使用cmake可以更加便捷的帮助我们管理大型项目

CMake使用

注释

- 单行注释:

# 这是单行注释

- 多行注释:

#[[

这是多行注释

]]

入门案例

- 程序结构如下:

./Cmake-demo1/

├── add.c

├── app.c

├── div1.c

├── head.h

└── sub.c

- 在这一个目录中编写

CMakeLists.txt

cmake_minimum_required(VERSION 3.25.0)

project(calc)

add_executable(app app.c div1.c add.c sub.c)

- 程序解释如下:

cmake_minimum_required表示使用的cmake的最低版本要求,可选project指定项目的基本信息,包含名称,语言等信息add_excutable定义工程生成一个可执行程序,这里可以指定多个可执行程序

project可选参数如下:

# PROJECT 指令的语法是:

project(<PROJECT-NAME> [<language-name>...])

project(<PROJECT-NAME>

[VERSION <major>[.<minor>[.<patch>[.<tweak>]]]]

[DESCRIPTION <project-description-string>]

[HOMEPAGE_URL <url-string>]

[LANGUAGES <language-name>...])

add_excutable使用

add_excutable(可执行程序名称,源文件名称)

- 执行构建操作:

cmake CMakeLists.txt所在的路径用于执行CMakeLists.txt- 自动生成了

makefile执行make命令即可得到可执行程序

- 执行

cmake 目录命令之后的文件夹内容如下:

.

├── add.c

├── app

├── app.c

├── CMakeCache.txt

├── CMakeFiles

│ ├── 3.28.3

│ │ ├── CMakeCCompiler.cmake

│ │ ├── CMakeCXXCompiler.cmake

│ │ ├── CMakeDetermineCompilerABI_C.bin

│ │ ├── CMakeDetermineCompilerABI_CXX.bin

│ │ ├── CMakeSystem.cmake

│ │ ├── CompilerIdC

│ │ │ ├── a.out

│ │ │ ├── CMakeCCompilerId.c

│ │ │ └── tmp

│ │ └── CompilerIdCXX

│ │ ├── a.out

│ │ ├── CMakeCXXCompilerId.cpp

│ │ └── tmp

│ ├── app.dir

│ │ ├── add.c.o

│ │ ├── add.c.o.d

│ │ ├── app.c.o

│ │ ├── app.c.o.d

│ │ ├── build.make

│ │ ├── cmake_clean.cmake

│ │ ├── compiler_depend.make

│ │ ├── compiler_depend.ts

│ │ ├── DependInfo.cmake

│ │ ├── depend.make

│ │ ├── div1.c.o

│ │ ├── div1.c.o.d

│ │ ├── flags.make

│ │ ├── link.txt

│ │ ├── progress.make

│ │ ├── sub.c.o

│ │ └── sub.c.o.d

│ ├── cmake.check_cache

│ ├── CMakeConfigureLog.yaml

│ ├── CMakeDirectoryInformation.cmake

│ ├── CMakeScratch

│ ├── Makefile2

│ ├── Makefile.cmake

│ ├── pkgRedirects

│ ├── progress.marks

│ └── TargetDirectories.txt

├── cmake_install.cmake

├── CMakeLists.txt

├── div1.c

├── head.h

├── Makefile

└── sub.c

- 可见如果在当前目录中执行

CMake就会导致的当前目录结构十分混乱,所以一般都需要新建一个build目录,在build目录中执行构建操作 build目录中的构建结果如下:

.

├── app

├── CMakeCache.txt

├── CMakeFiles

├── cmake_install.cmake

└── Makefile

set函数的使用

- 可以用于设置变量的值(变量之间使用

;或者空格进行分割)

# SET 指令的语法是:

# [] 中的参数为可选项, 如不需要可以不写

SET(VAR [VALUE] [CACHE TYPE DOCSTRING [FORCE]])

- 使用方式如下:

cmake_minimum_required(VERSION 3.25.0)

project(calc)

set(SRC app.c div1.c add.c sub.c)

add_executable(app ${SRC})

- 指定使用的

C++标准

- 如果使用

g++指定方式如下:

$ g++ test.c -std=c++11 -o test

- 使用

set设置CMAKE_CXX_STANDARD变量的值

set(CMAKE_CXX_STANDARD 11)

- 在使用

cmake命令进行构建的时候,指定DCMAKE_CXX_STANDARD这一个宏定义的值

$ cmake CMakeLists.txt所在的目录 -DCMAKE_CXX_STANDARD 11

- 指定输出路径

- 直接修改

EXECUTABLE_OUTPUT_PATH即可

set(EXECUTABLE_OUTPUT_PATH, 目录名)

- 使用

set之后的CMakeLists.txt

cmake_minimum_required(VERSION 3.25.0)

project(calc)

set(SRC app.c div1.c add.c sub.c)

# set(CMAKE_CXX_STANDARD 11)

set(HOME /home/loser/公共/C++后端/Linux系统编程/code/Cmake/Cmake-demo1)

set(EXECUTABLE_OUTPUT_PATH ${HOME}/out)

add_executable(app ${SRC})

搜索文件

- 使用

aux_source_directory搜索路径

aux_source_directory(需要搜索的路径,存储搜索结果的变量)

- 改变项目的目录结构

.

├── build

├── CMakeFiles

│ ├── 3.28.3

│ │ ├── CMakeCCompiler.cmake

│ │ ├── CMakeCXXCompiler.cmake

│ │ ├── CMakeDetermineCompilerABI_C.bin

│ │ ├── CMakeDetermineCompilerABI_CXX.bin

│ │ ├── CMakeSystem.cmake

│ │ ├── CompilerIdC

│ │ │ ├── a.out

│ │ │ ├── CMakeCCompilerId.c

│ │ │ └── tmp

│ │ └── CompilerIdCXX

│ │ ├── a.out

│ │ ├── CMakeCXXCompilerId.cpp

│ │ └── tmp

│ ├── app.dir

│ │ ├── add.c.o

│ │ ├── add.c.o.d

│ │ ├── app.c.o

│ │ ├── app.c.o.d

│ │ ├── build.make

│ │ ├── cmake_clean.cmake

│ │ ├── compiler_depend.make

│ │ ├── compiler_depend.ts

│ │ ├── DependInfo.cmake

│ │ ├── depend.make

│ │ ├── div1.c.o

│ │ ├── div1.c.o.d

│ │ ├── flags.make

│ │ ├── link.txt

│ │ ├── progress.make

│ │ ├── sub.c.o

│ │ └── sub.c.o.d

│ ├── cmake.check_cache

│ ├── CMakeConfigureLog.yaml

│ ├── CMakeDirectoryInformation.cmake

│ ├── CMakeScratch

│ ├── Makefile2

│ ├── Makefile.cmake

│ ├── pkgRedirects

│ ├── progress.marks

│ └── TargetDirectories.txt

├── CMakeLists.txt

├── inc

│ └── head.h

├── out

│ └── app

└── src

├── add.c

├── app.c

├── div1.c

└── sub.c

- 使用方式如下:

cmake_minimum_required(VERSION 3.25.0)

project(calc)

# set(SRC app.c div1.c add.c sub.c)

# 搜索头文件

include_directories(${PROJECT_SOURCE_DIR}/inc)

aux_source_directory(${CMAKE_CURRENT_SOURCE_DIR}/src SRC)

# set(CMAKE_CXX_STANDARD 11)

set(HOME /home/loser/公共/C++后端/Linux系统编程/code/Cmake/Cmake-demo1)